Ob Elon Musk sein Unternehmen Tesla tatsächlich zum Erfolg führen kann, muss er noch beweisen. Was er auf jeden Fall beherrscht: Angst zu machen vor künstlicher Intelligenz, kurz KI genannt. Die Technologie sei "die größte Gefahr für die Menschheit" und "viel gefährlicher als Atomwaffen", wiederholt er bei jeder Gelegenheit. Musk liefert knackige Zitate, Medien freuen sich über Schlagzeilen, Leser gruseln sich vor KI.

Viele Forscher, die sich seit Jahrzehnten mit diesem Thema beschäftigen, nervt dieser Alarmismus. Er könne kaum eine Zeitung aufschlagen, ohne dass Musk darin vor KI warne, die einen Weltkrieg auslösen werde, schreibt der australische Professor Toby Walsh im Magazin Wired. Er glaubt nicht, dass wir uns vor dem fürchten müssen, was Leute wie er Singularität nennen: also den Zeitpunkt, an dem Maschinen beginnen, sich von selbst weiterzuentwickeln.

Musk habe recht: KI-Forschung müsse reguliert werden. Aber nicht, weil sonst Roboter die Macht übernähmen, sondern weil Unternehmen und Staaten zu sehr auf die vermeintliche Intelligenz der Maschinen vertrauten. Der Terminator wird Science-Fiction bleiben, doch ohne Regeln droht eine Dystopie. Die folgenden Beispiele zeigen, dass technologischer Fortschritt auch nach hinten losgehen kann.

Maschine foppt Mensch

Auf einer Konferenz Anfang Mai spielte Google-Chef Sundar Pichai einen Anruf ab. Man hörte eine weibliche Stimme, die einen Tisch in einem Restaurant reserviert. Das Publikum vor Ort bejubelte das scheinbar banale Gespräch. In sozialen Medien hielten sich zwei Reaktionen die Waage: Die eine Hälfte war begeistert, die andere entsetzt. "Das ist schrecklich und so offensichtlich falsch", schrieb die Soziologin Zeynep Tufekci.

Die Zuschauer hatten zum ersten Mal miterlebt, wie KI menschliches Sprechverhalten so perfekt nachahmte, dass die Mitarbeiterin des Restaurants am anderen Ende der Leitung nicht merkte, dass sie mit einer Maschine sprach.

Pichai beteuerte mehrmals, dass der Anruf genau so stattgefunden habe. Inzwischen sind Zweifel aufgetaucht, möglicherweise hat Google die Aufzeichnung zusammengeschnitten oder nachträglich bearbeitet. Entscheidender ist ohnehin die Debatte, die der Anruf ausgelöst hat. Muss sich KI zu erkennen geben, wenn sie mit Menschen direkt kommuniziert?

Keine Science Fiction mehr: Fachleute von Oxford bis Google rufen die Menschheit auf, die Technologie genau im Auge zu behalten.

Die Frage geht weit über den Google-Assistenten hinaus, der Termine vereinbaren kann. Was passiert, wenn Enkeltrick-Betrüger Software einsetzen, die dann automatisiert massenhaft Rentner anruft? Müssen Bots in sozialen Netzwerken gekennzeichnet werden, damit Nutzer verstehen, dass sie mit einem Computer chatten? KI-Forscher wie Walsh fordern deshalb, autonome Systeme so zu gestalten, dass sie nicht mit Menschen verwechselt werden können.

Algorithmen entscheiden über Meinungsfreiheit

Tech-Konzerne beschäftigen Zehntausende Menschen, um den Schmutz aus dem Netz zu fischen. Die digitale Müllabfuhr klickt sich durch verstörende Bilder und Videos, sie sichtet und löscht Darstellungen extremer Gewalt. Um Facebook- und Youtube-Nutzern den Anblick zu ersparen, riskieren billige Hilfskräfte in Schwellen- und Entwicklungsländern ihre psychische Gesundheit.

Nebenbei füttern sie Datenbanken und trainieren Software, die ihre Jobs überflüssig machen könnte. Ständig spricht Facebook-Chef Mark Zuckerberg von "KI-Werkzeugen", die Facebook in Zukunft sauber halten sollen. Bei einer Anhörung vor dem US-Kongress nahm er mehr als 30 Mal Bezug auf KI, die selbstständig Inhalte löschen solle, wenn diese gegen Facebooks Gemeinschaftsstandards verstoßen.

Doch tilgt KI im Zweifel eben nicht nur Terrorpropaganda und Kindesmissbrauch, bei denen die Entscheidung eindeutig ist. Selbst Juristen sind uneins, wo die Grenze zwischen Meinungsfreiheit und Zensur verläuft. Zahlreiche Beispiele aus den vergangenen Jahren haben immer wieder gezeigt, dass es keine gute Idee ist, Algorithmen darüber entscheiden zu lassen. " Die Maschine war's", darf keine Ausrede für Facebook oder Youtube werden, wenn mal wieder etwa ein Satire-Video gesperrt wurde, weil KI nicht in der Lage ist, Ironie zu erkennen.

KI erzeugt täuschend echte Fake-Videos

Im April veröffentlichte das Medienportal Buzzfeed ein Video, in dem ein Mann vor gefälschten Videos warnt. Er sieht aus wie Barack Obama, spricht wie Obama, ist aber nicht Obama. Tatsächlich handelt es sich um Schauspieler Jordan Peele. Das Video ist ein sogenannter Deepfake.

Die SZ-Redaktion hat diesen Artikel mit einem Inhalt von X Corp. angereichert

Um Ihre Daten zu schützen, wurde er nicht ohne Ihre Zustimmung geladen.

Ich bin damit einverstanden, dass mir Inhalte von X Corp. angezeigt werden. Damit werden personenbezogene Daten an den Betreiber des Portals zur Nutzungsanalyse übermittelt. Mehr Informationen und eine Widerrufsmöglichkeit finden Sie untersz.de/datenschutz.

Künstliche neuronale Netze, die natürlichen Vernetzungen von Nervenzellen nachempfunden sind, können Ton- und Videoaufnahmen mittlerweile so perfekt fälschen, dass sie kaum noch vom Original zu unterscheiden sind. Mit Anwendungen wie der Fakeapp können auch normale Nutzer ohne besondere technische Fertigkeiten erschreckend gute Fake-Videos erstellen.

Viele mögen es lustig finden, wenn der künstliche Obama sagt: "Trump ist ein kompletter Vollidiot. So etwas würde ich natürlich nie sagen - zumindest nicht öffentlich." Weniger lustig wird es, wenn auf Twitter plötzlich ein manipuliertes Video kursiert, in dem Kim Jong-un verkündet, soeben eine Atomrakete in Richtung USA abgeschossen zu haben. Ob Trumps Berater genug Zeit haben, ihn über Deepfakes aufzuklären, bevor er den roten Knopf drückt? Stimmungsmache mit gefälschten Videos ist bereits Realität: Eine belgische Partei hat am Sonntag einen Trump-Fake in sozialen Medien verbreitet, in dem der Präsident Belgien vermeintlich dazu auffordert, aus dem Pariser Klimaabkommen auszusteigen.

Experten warnen vor einer Ära der Desinformation. Aviv Ovadya, der bereits die Fake-News-Flut im US-Wahlkampf vorausgesagt hatte, sieht die Menschheit auf die "Infokalypse" zusteuern. Falschnachrichten überschwemmen das Netz, doch lange Zeit galten zumindest Videos als fälschungssicher. Jetzt muss man auch seinen Augen und Ohren misstrauen.

Firmen überwachen Mitarbeiter

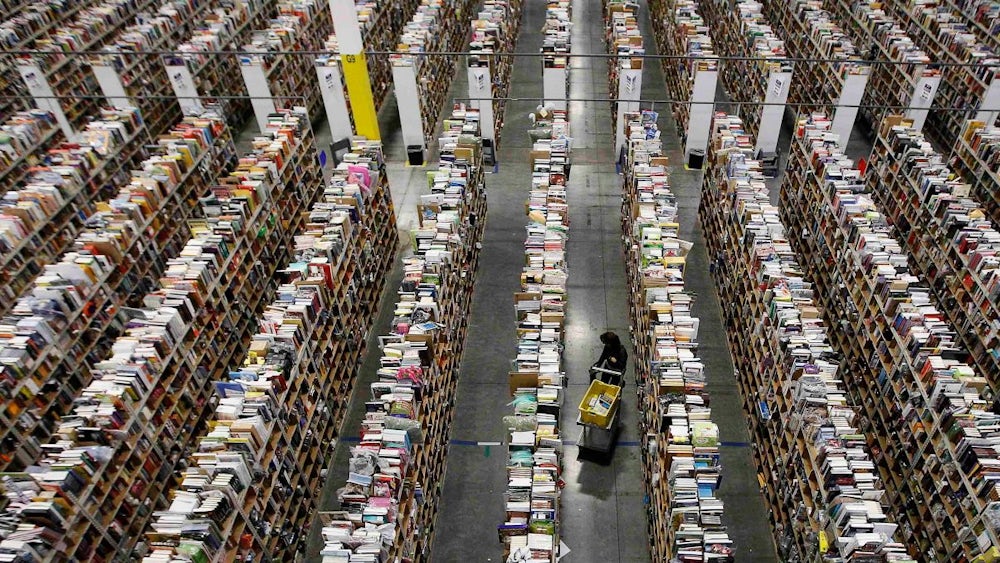

Bei Amazon zu bestellen, ist bequem. Bei Amazon zu arbeiten, ist oft das Gegenteil. In den Logistikzentren wird jeder Handgriff gefilmt. Die Überwachung könnte künftig noch totaler werden: Anfang des Jahres bekam Amazon zwei Patente für ein Armband zugesprochen, das alle Bewegungen der Mitarbeiter minutiös verfolgt. Dank Ultraschall- und Funktechnologie soll das Armband immer wissen, wo sich die Hände des Trägers in Relation zum Inventar in den Regalen befinden. Vibrationen könnten dem Mitarbeiter signalisieren, dass er die falsche Ware verpackt.

Amazon bestreitet, das Armband einsetzen zu wollen, um Angestellte zu überwachen. Es solle dazu dienen, Arbeitsabläufe der Logistikmitarbeiter zu vereinfachen - falls es überhaupt jemals zur Anwendung komme. Selbst wenn man Amazon glaubt, bleibt das Missbrauchspotenzial enorm. Millionen Menschen schuften in Schwellenländern im Akkord, um Smartphones zu bauen, die sie sich nie werden leisten können. Gewerkschaften und Arbeitnehmerrechte sind für sie Fremdworte. Ihre Arbeitgeber fänden Überwachungs-Armbänder bestimmt praktisch. Die Menschen würden dadurch noch ein Stück weiter zu Robotern degradiert.

Dass Länder wie China wenig Hemmungen kennen, was Überwachung angeht, zeigt ein aktuelles Beispiel. Eine Schule in der Stadt Hangzhou im Osten Chinas testet ein Gesichtserkennungsystem: Drei Kameras beobachten die Schüler und interpretieren deren Gesichtsausdruck. Wenn die Software glaubt, ein unaufmerksames Kind erkannt zu haben, wird der Lehrer benachrichtigt. "Seit die Kameras im Klassenzimmer hängen, traue ich mich nicht mehr, mich ablenken zu lassen", sagte ein Schüler. "Es ist, als ob mich unheimliche Augen ständig beobachteten."

Dieser Text wurde zuerst am 19.05.2018 veröffentlicht.