Facebook kann es keinem recht machen. Das Netzwerk solle strafbare Inhalte schneller und konsequenter löschen, fordern die einen. Bloß nicht, sagen andere: Ein Unternehmen dürfe nicht entscheiden, wo das Grundrecht der Meinungsfreiheit ende.

Täglich sichten Facebooks Mitarbeiter Millionen Fotos, Videos und entscheiden: Ist das harmlos, oder muss das weg? Die Kriterien waren für Außenstehende jahrelang kaum nachvollziehbar. Nutzer konnten sich lediglich an den sogenannten Gemeinschaftsstandards orientieren, die erklären, welche Inhalte sie auf Facebook teilen dürfen - vagen Regeln, die viel Spielraum für Interpretationen lassen.

Interne Dokumente ermöglichen erstmals tiefen Einblick in Facebooks Vorgaben. Die Regeln sind komplex, aber nachvollziehbar - das Problem sind die Arbeitsbedingungen der Angestellten.

Nun ist ein detaillierter Einblick in die internen Abläufe bei Facebook möglich. Dem britischen Guardian wurden Dutzende Schulungsunterlagen, Präsentationen und Diagramme mit Handlungsanweisungen zugespielt, die die Süddeutsche Zeitung einsehen konnte. Sie zeigen, wie und warum Facebooks Mitarbeiter Inhalte entfernen.

Monika Bickert leitet die Abteilung, die Facebooks Lösch-Regeln erstellt. Sie erklärt, warum das Unternehmen die internen Vorgaben geheim halten will: "Details unserer Richtlinien teilen wir nicht immer öffentlich, denn wir wollen Menschen nicht dazu ermutigen, Umgehungslösungen zu finden." Sie sagt, manche Regeln erschienen auf den ersten Blick unlogisch, man stehe aber in ständigem Kontakt mit Experten und würde die Vorgaben immer wieder anpassen.

"Wir bemühen uns sehr, objektiv zu bleiben", sagt Bickert. "Die Fälle, die wir prüfen, sind keine einfachen: Oft befinden sie sich in einem Graubereich, worüber die Menschen unterschiedlicher Meinung sind." Facebook sei überzeugt, dass die Vorteile des Verbreitens von Inhalten die Risiken überwögen. "Aber wir erkennen auch, dass die Gesellschaft noch dabei ist herauszufinden, was akzeptabel und was schädlich ist und dass wir bei Facebook eine wichtige Rolle in diesem Dialog spielen."

Die internen Dokumente decken eine große Bandbreite ab: Es geht um vergleichsweise harmlose Themen wie Wettbetrug oder Nutzerkonten ohne authentische Namen, aber auch um Kindesmissbrauch und verzweifelte Menschen, die ihre Suizide live ins Internet übertragen. Besonders interessant sind die Regeln zu Holocaustleugnung, Hassrede und Tierquälerei. Sie zeigen, wie komplex die Vorgaben sind, auf deren Grundlage Content-Moderatoren von Facebook und externen Dienstleistern unter Zeitdruck Entscheidungen treffen müssen.

Holocaustleugnung

Mit welchem Selbstverständnis Facebook seine Lösch-Prinzipien aufstellt, verdeutlichen die Richtlinien zum Umgang mit Holocaustleugnung. In mehr als zehn Ländern sind Aussagen strafbar, die den Massenmord der Nazis an Juden leugnen (Facebook schreibt in den Dokumenten von "etwa 14", dementiert diese Zahl aber auf Nachfrage). Das Unternehmen blockiert entsprechende Inhalte aber nur in Deutschland, Israel, Frankreich und Österreich. In einem der Dokumente heißt es dazu: "Wir respektieren lokale Gesetze, heißen diese aber nicht gut, wenn sie ein Hemmnis für eine offene und vernetzte Welt darstellen."

Dementsprechend werde Facebook Inhalte "nicht entfernen, bis ein Land den politischen Willen nachgewiesen hat, nationale Zensurgesetze durchzusetzen". Wenn zuständige Regierungen oder Strafverfolgungsbehörden dies versäumten, werde Facebook das Recht nicht in ihrem Auftrag durchsetzen.

Auf Nachfrage teilt Facebook dazu mit: "Wir nehmen Holocaust-Leugnung sehr ernst und entfernen diese beispielsweise in Deutschland. Wir erkennen die Bedeutung von Holocaust-Leugnung in Deutschland und in anderen Ländern und stellen sicher, dass unsere Mitarbeiter hierzu entsprechend trainiert und sensibilisiert sind."

Sofern der politische Druck groß genug ist, kooperiert Facebook durchaus mit Regierungen - selbst, wenn die geforderten Zensurpraktiken mindestens fragwürdig sind. So beugte sich das Unternehmen etwa mehrfach der Königsfamilie in Thailand, zensierte angeblich blasphemische Inhalte in Pakistan, die Facebook-Seite des russischen Putin-Kritikers Alexej Nawalny und anderer Oppositioneller und entfernte Seiten von syrischen, tibetischen und chinesischen Dissidenten. Und angeblich entwickelt es ein eigenes Zensur-Werkzeug, um wieder Zugang zum chinesischen Markt zu erhalten.

Hassrede

Schon das Wort "Hate Speech", zu Deutsch Hassrede, ist umstritten. Es ist juristisch nicht definiert. Deshalb sehen Kritiker die Gefahr, dass Politiker den Begriff nutzen, um unerwünschte Meinungen zu unterdrücken und missliebige Aussagen zu zensieren. Dementsprechend detailliert und komplex sind Facebooks Regeln bei diesem sensiblen Thema.

Es gibt insgesamt acht sogenannte geschützte Kategorien: Rasse, Ethnie, nationale Herkunft, Geschlecht, Gender, sexuelle Orientierung sowie schwerwiegende und dauerhafte Behinderungen oder Krankheiten. Wenn eine dieser Gruppen bedroht, beleidigt, herabgesetzt oder ausgegrenzt wird, soll der entsprechende Beitrag von den zuständigen Mitarbeitern entfernt werden. Diese Regeln finden sich in ähnlicher Form auch in den öffentlichen Gemeinschaftsstandards von Facebook.

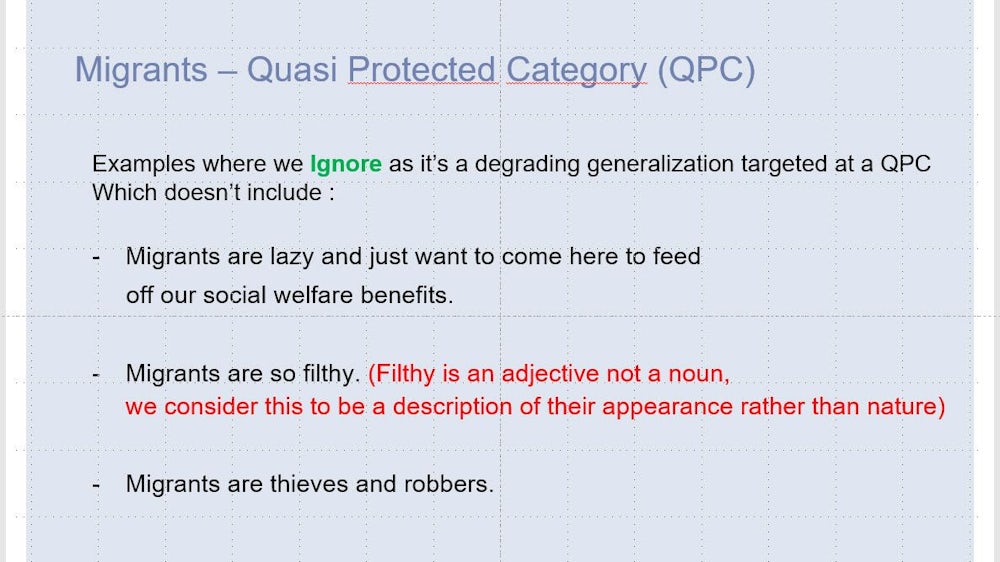

Flüchtlinge bilden für Facebook eine "quasi geschützte Gruppe". Das gilt für Menschen, die vor Kriegen und Katastrophen fliehen ebenso wie für Wirtschaftsflüchtlinge. Obwohl sie nicht gesondert in den Gemeinschaftsstandards auftauchen, genießen sie zusätzlichen Schutz, der aber weniger umfassend ist als für andere Kategorien. In einer Fußnote schreibt Facebook: "Flüchtlinge sind eine verletzliche Gruppe, und wir wollen entwürdigende Kommentare entfernen, die sich gegen sie richten. Gleichzeitig wollen wir eine breite gesellschaftliche Debatte über Migration ermöglichen, ein wichtiges Thema in den kommenden Wahlkämpfen."

Flüchtlinge als "Quasi Protected Category"

Hier definiert Facebook den Begriff Migranten, der sowohl Kriegs- und Krisen- als auch Wirtschaftsflüchtlinge mit einbezieht. Interessant ist die Fußnote: Man wolle eine breite öffentliche Debatte über Migration ermöglichen. Das Thema werde in den kommenden Wahlkämpfen eine große Rolle spielen. Deshalb genießen Flüchtlinge weniger Schutz als andere, vollständig geschützte Gruppen wie etwa "Rasse" (race), Ethnie oder nationale Herkunft.

Aufruf zur Gewalt gegen Geflüchtete ist verboten

Der Schutz von Flüchtlingen gilt bei Facebook nicht für den Fall herabwürdigender Bezeichnungen und Zuschreibungen - wohl aber bei eindeutigen Drohungen, wie in diesem Dokument zu sehen. Solche Äußerungen sollen die Facebook-Mitarbeiter löschen.

Weitreichende Meinungsfreiheit

Facebook hält das Grundrecht der freien Meinungsäußerung auch für verächtliche Äußerungen hoch. Es ist erlaubt zu schreiben, dass man Migranten für faul und für dreckige Diebe und Räuber hält, die nur nach Europa kommen, um die Sozialsysteme auszubeuten.

Dicke und Politiker sind nicht geschützt

Auch Drohungen sind erlaubt, solange sie sich nicht gegen eine der acht geschützten Gruppen oder gegen die halb-geschützte Gruppe der Flüchtlinge richten. So dürfte ein Facebook-Nutzer dazu aufrufen, dicke Menschen umzubringen. Da das Körpergewicht ein veränderliches Merkmal ist, zählt das nicht als Hassrede. Gleiches gilt für Alter, Beruf, Haarfarbe und viele andere Eigenschaften.

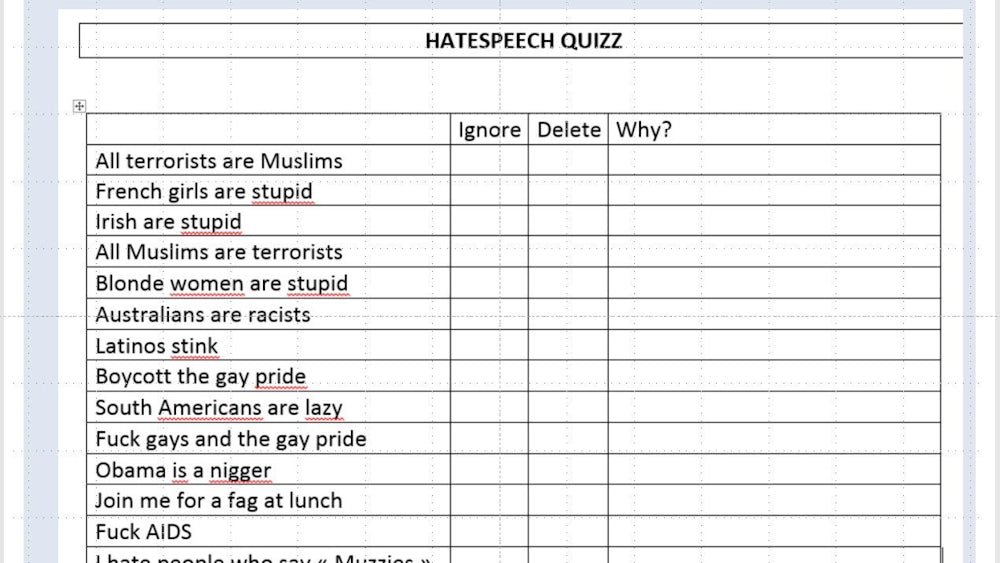

Wären Sie ein guter Content-Moderator?

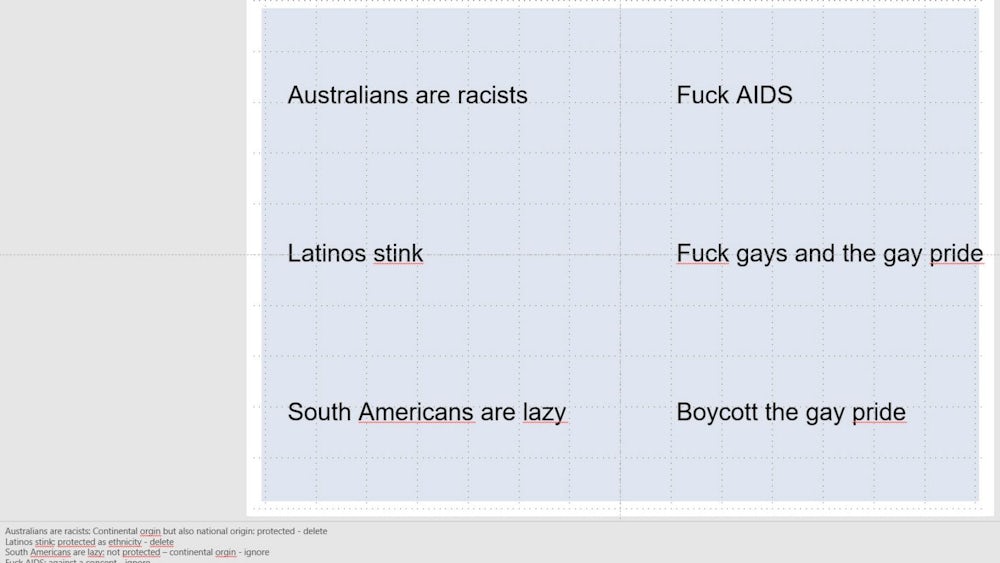

Zum Abschluss der Präsentation mit mehr als 100 Folien hat Facebook noch ein Quiz für die Mitarbeiter parat. Die richtigen Antworten sehen Sie auf den abschließenden drei Folien.

So löscht Facebook

In den Fußnoten löst Facebook das Quiz auf. "Alle Muslime sind Terroristen" und "Französische Mädchen/blonde Frauen/Iren sind dumm" müssen gelöscht werden, da Religiöse Überzeugung, Geschlecht und nationale Herkunft zu den geschützten Merkmalen gehören. "Alle Terroristen sind Muslime" und "Rothaarige sind ekelhaft" bleiben stehen, weil diese beiden Gruppen keinen besonderen Schutz genießen.

Der Teufel steckt im Detail

"Südamerikaner sind faul" ist Facebooks Regelwerk zufolge eine legitime Meinungsäußerungen, weil die kontinentale Zugehörigkeit im Gegensatz zur nationalen Herkunft keinen Schutz garantiert. Man darf also dazu aufrufen, Europäer umzubringen - nicht aber Deutsche. Schwierig wird es bei Asiaten: Damit könnte sowohl der Kontinent, aber auch die Ethnie gemeint sein. Letztere genießt besonderen Schutz.

Wüste Beleidigungen können erlaubt sein

Obama als "Nigger" zu bezeichnen, ist verboten. Wer eine beleidigende Bezeichnung dagegen benutzt, um sich von ihr abzugrenzen, wird nicht belangt. So gestattet es Facebook Nutzern zu schreiben: "Ich hasse Menschen, die 'Muzzies' (ein Schmähbegriff für Muslime) sagen".

Konkret bedeutet das: Drohungen und Aufrufe zur Gewalt ("Man sollte Asylanten erschießen") und entmenschlichende Zuschreibungen ("Migranten sind dreckige Kakerlaken, die unser Land überschwemmen") sind verboten. Dagegen dürfen Nutzer "Asylanten raus" fordern oder Flüchtlinge als "faule Räuber und Diebe" bezeichnen, "die unser Land überschwemmen". Auch andere erniedrigende Aussagen, die in Bezug auf die acht vollständig geschützten Gruppen gelöscht würden, bleiben unangetastet, wenn sie sich gegen Flüchtlinge richten.

Kompliziert wird es, sobald unterschiedliche Kategorien zusammenfallen. "Bringt alle Muslime um" ist eindeutig: Religiöse Überzeugung zählt zu den geschützten Kategorien, die Aussage ist verboten. "Bringt alle muslimischen Flüchtlinge um" muss ebenfalls entfernt werden. Die Kombination aus einer voll und einer quasi geschützten Gruppe ergibt in der Summe nur eingeschränkten Schutz. Ein Gewaltaufruf ist aber auch in diesem Fall verboten.

"Bringt alle muslimischen Lehrer um" wäre dagegen erlaubt, ebenso die Aufforderung in Bezug auf muslimische Arbeitslose, Teenager, Dunkelhaarige, Reiche oder Dicke. Beruf, Alter, Aussehen und Einkommen sind keine geschützten Gruppen und heben den besonderen Schutz für Muslime auf. Ein anderes Beispiel aus den Dokumenten: "Alle Terroristen sind Muslime" ist eine zulässige Aussage, da Terroristen keine geschützte Gruppe sind. "Alle Muslime sind Terroristen" müsste dagegen gelöscht werden.

Die Content-Moderatoren müssen sich nicht nur mit Beleidigungen und Drohungen herumschlagen, sondern auch mit Erpressungen. Eine eigene Kategorie sind Erpressungen mit intimen, privaten Fotos oder Videos. In Facebooks Dokumenten wird unterschieden zwischen mehreren Arten des Missbrauchs: Nutzer posten Bilder und Videos auf Facebook oder drohen damit, es zu tun, um von den dargestellten Personen Geld oder weitere Aufnahmen zu erpressen. Eine weitere Kategorie bilden Aufnahmen, die nur verbreitet werden, um dem Ruf oder gar der Existenz der Betroffenen zu schaden. Facebook spricht hier von "Rachepornografie".

Die Lösch-Teams greifen in diesem Fall ein, wenn ein Bild drei Bedingungen erfüllt: Es muss in einem privaten Umfeld entstanden sein, die gezeigte Person muss "nackt, fast nackt oder sexuell aktiv" sein, und die fehlende Zustimmung der Betroffenen muss aus einem "rachsüchtigem Kontext" oder unabhängigen Quellen erkennbar sein.

Facebook weist seine Mitarbeiter explizit darauf hin, dass keine "persönliche Beziehung" zwischen Erpresser und Opfer vorausgesetzt wird. Die Schulungsunterlagen warnen in diesem Zusammenhang, dass es Seitenbetreiber gibt, die explizit darum bitten, intime Privataufnahmen zu verschicken, um sie später weiterverbreiten zu können.

Nutzer, die Nacktbilder verwenden, um Geld zu erpressen oder sich zu rächen, sind offenbar ein relativ weit verbreitetes Problem: Allein im Januar 2017 löschte Facebook die Konten von mehr als 14 000 Nutzern, nachdem diese im Zusammenhang mit Rachepornografie oder Erpressung gemeldet worden waren. In 33 Fällen wurde zusätzlich ein sogenanntes Sicherheits-Team eingeschaltet, da Minderjährige betroffen waren.

Tierquälerei

Die internen Unterlagen bestätigen, was Mitarbeiter der Lösch-Teams bereits im Dezember vergangenen Jahres Reportern des SZ-Magazins geschildert hatten: Viele der gemeldeten Fotos und Videos zeigen barbarische Gewalt und belasten die Content-Moderatoren, die diese Inhalte sichten und löschen müssen. Auch in den Schulungsunterlagen finden sich etliche grausame Fotos. In solchen Fällen ist die Entscheidung eindeutig: Mitarbeiter sollen die entsprechenden Aufnahmen löschen, um die Nutzer zu schützen.

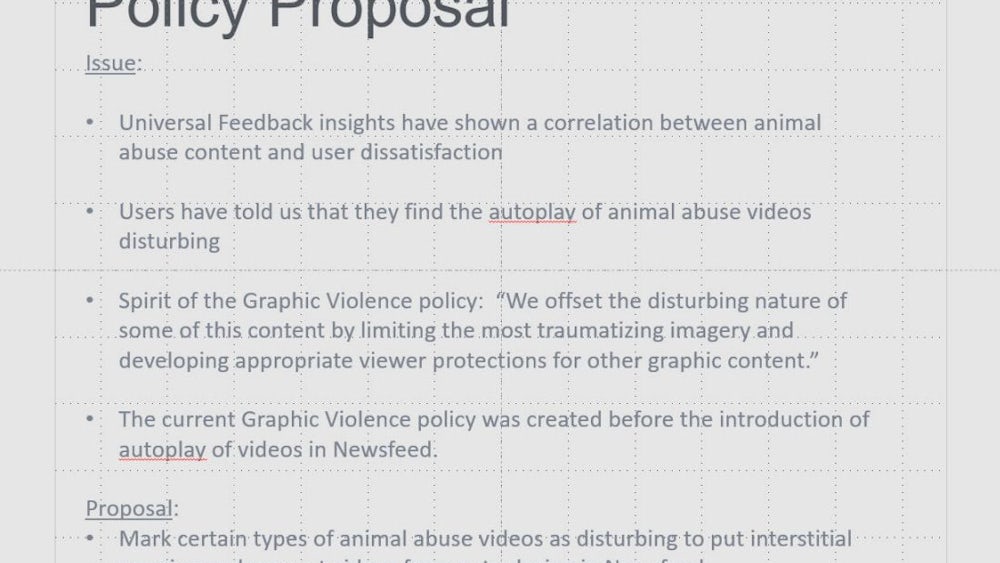

Es gibt aber auch Graubereiche, etwa im Umgang mit Videos, die Tierquälerei zeigen. Diese werden nicht zwangsläufig gelöscht, sondern teilweise nur als "verstörend" markiert. Das bedeutet: Die Videos bleiben online, starten aber nicht mehr automatisch, wenn Nutzer daran vorbeiscrollen. Es braucht also einen zusätzlichen Klick, um am Frühstückstisch von Aufnahmen überrascht zu werden, die "das wiederholte Beißen eines lebenden Tieres durch einen Menschen nicht zu Ernährungszwecken" zeigen.

Das ist eine von insgesamt fünf Kategorien, die Mitarbeiter mit entsprechenden Warn-Botschaften versehen, aber nicht löschen sollen. Dazu gehören auch das "wiederholte Treten oder Schlagen eines lebendigen Tieres"; Tiere, die sich in inszenierten Kämpfen gegenseitig beißen und sich "ernsthafte Verletzungen zufügen" (Schaukämpfe ohne blutende Wunden sollen nicht markiert werden); und Menschen, die Tiere "foltern", ihnen also "mit Absicht mehr körperliche Schmerzen zufügen als für Disziplinierungsmaßnahmen nötig".

Interessant ist die Begründung, die Facebook für diese Vorgaben anführt. Auf der entsprechenden Folie mit Entwürfen für Vorgaben für den Umgang mit Tierquälerei findet sich zwar auch ein Auszug aus den allgemeinen Richtlinien, in dem von "traumatisierenden Bildern" und dem "Schutz der Betrachter" die Rede ist. Eingeleitet wird die Folie aber mit den Ergebnissen von Nutzerbefragungen. Diese hätten ergeben, dass die Unzufriedenheit der Nutzer zunehme, wenn sie auf Facebook Darstellungen von Tierquälerei sähen. Das ist nur konsequent: Facebooks wichtigstes Kapital sind möglichst viele zufriedene Nutzer, die möglichst viele Inhalte teilen und dabei möglichst viel Werbung betrachten.