"Ein Roboter darf keinen Menschen verletzen." So lautet das erste Robotergesetz des Science-Fiction-Autors Isaac Asimov. Er formulierte 1942 insgesamt drei Gesetze für Roboter, später kam noch ein viertes hinzu. Heute arbeiten Länder wie die USA, China, Großbritannien und Israel an autonomen Kampfsystemen. Sie sollen Menschen verletzen und töten, ohne auf menschliche Befehle zu warten.

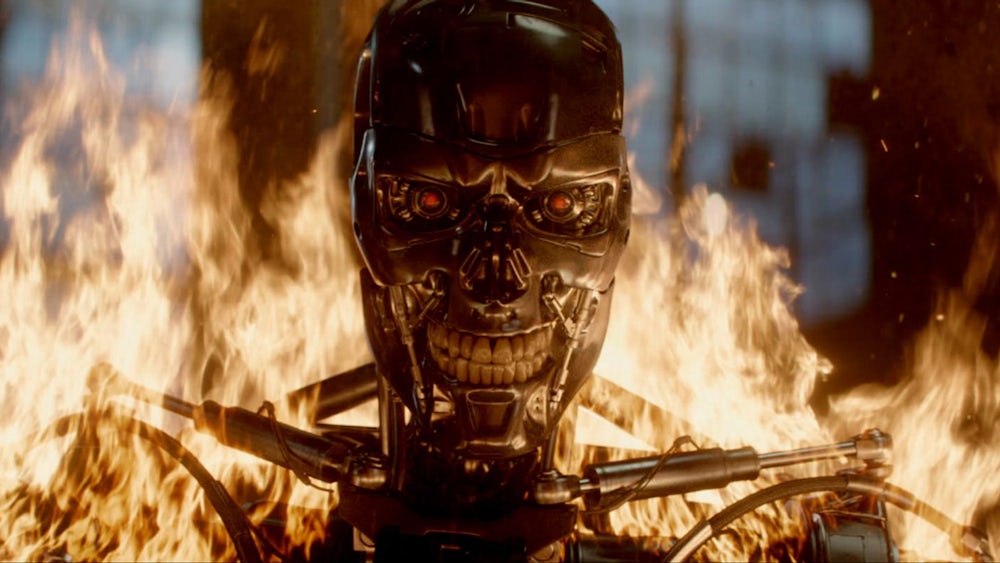

Das erste Bild, das viele mit dem Begriff "Killerroboter" assoziieren, ist Arnold Schwarzenegger als Terminator. In der Realität werden die Kampfmaschinen noch weniger menschlich aussehen, aber trotzdem tödlich sein. Gebaut wird an U-Booten, die Ziele automatisch anvisieren und zerstören, unbemannten Drohnen, die selbstständig Raketen abfeuern und Grenzanlagen, die ohne menschlichen Befehl gezielt schießen. Schon in wenigen Jahren sollen die ersten ausgereiften autonomen Kampfsysteme die Kriege dieser Welt entscheiden.

Dürfen Staaten "tödlichen autonome Waffensysteme" einsetzen? Darüber beraten derzeit Rüstungsexperten bei der Uno in Genf. Die wichtigsten Fragen und Antworten.

Doch der Widerstand wird stärker: In dieser Woche haben mehr als 160 Organisationen aus Forschung und Wirtschaft sowie 2400 Experten ein Abkommen unterzeichnet und darin versprochen, keine Killerroboter zu bauen oder an ihrer Entstehung mitzuwirken. Darunter sind etwa Elon Musk, der Gründer von Tesla und Space X, die Google-Tochter Deepmind sowie mehrere renommierte Forscher auf dem Gebiet künstlicher Intelligenz (KI). "Wir werden Entwicklung, Produktion, Handel oder Verwendung von tödlichen autonomen Waffen nicht unterstützen oder daran teilnehmen", heißt es in dem Abkommen. Die Entscheidung, "einen Menschen zu töten, sollte niemals einer Maschine übertragen werden".

Die Büchse der Pandora nicht öffnen

Zudem fordern die Unterzeichner Regierungen auf, Killerroboter staatlich zu regulieren. Kritik an Killerrobotern verbindet sich oft mit Warnungen vor KI. Sie soll die Grundlage bilden, auf der Killerroboter Entscheidungen über Leben und Tod treffen sollen.

Auch die Unterschrift von Jürgen Schmidhuber findet sich unter dem Text. Der deutsche Informatiker forscht in der Schweiz und gehört zu den Pionieren der KI. "Unsere Forderungen wird man wohl kaum sofort umsetzen, aber mit meiner Unterschrift kann ich dazu beitragen, dass sich die Öffentlichkeit dessen bewusst wird, was da läuft", sagt er.

Das Versprechen, keine intelligenten Kampfmaschinen zu bauen, geht auf das Future of Life Institute zurück, das die Risiken von KI untersucht. Im Beirat des unabhängigen amerikanischen Forschungsinstituts sitzt unter anderem Elon Musk, auch der britische Physiker Stephen Hawking war dort vertreten, bis er im März starb. Bereits im vergangenen August warnten mehr als 100 Unternehmer in einem offenen Brief des Instituts vor Killerrobotern: "Wenn diese Büchse der Pandora geöffnet ist, kann man sie nur schwer wieder schließen."

Ursprünglich harmlose Technik wird missbraucht

Die Arbeit an autonomen Waffensystemen macht nur einen kleinen Teil der KI-Entwicklung aus. "Die besten KI-Forscher arbeiten nicht an Waffen, sondern an Universitäten oder bei Unternehmen", sagt Schmidhuber. Er geht davon aus, dass etwa fünf Prozent der KI-Forschung für militärische Zwecke eingesetzt wird. Es gebe bereits einfache Varianten von Killerrobotern, die Menschen erkennen können. "Es ist gar nicht schwer, welche zu bauen. Und sie werden ständig besser."

Schmidhuber kritisiert, dass ursprünglich harmlose Technik missbraucht wird: "In München und Lugano hat meine Forschungsgruppe seit den 1990ern das neuronale Netz namens LSTM entwickelt, das nun Googles Spracherkennung auf Milliarden von Smartphones betreibt, oder jeden Tag Milliarden von Texten für Facebook übersetzt", sagt Schmidhuber. Allerdings wisse er von US-Kollegen, dass damit auch autonome Kampfdrohnen fliegen lernen. "Technologie kann immer missbraucht werden. Sollte die Staatengemeinschaft nicht nur Chemiewaffen ächten, sondern auch KI-Waffen?" Im Rahmen der Vereinten Nationen diskutieren Diplomaten bereits, autonome Kampfsysteme durch ein Zusatzprotokoll zur UN-Waffenkonvention zu ächten.

Auch die Bundesregierung hat die Brisanz der Thematik zumindest auf dem Papier erkannt. Im Koalitionsvertrag von CDU, CSU und SPD heißt es: "Autonome Waffensysteme, die der Verfügung des Menschen entzogen sind, lehnen wir ab. Wir wollen sie weltweit ächten." Gleichzeitig soll die Forschung in Deutschland ausgebaut werden. In dieser Woche hat das Bundeskabinett Eckpunkte einer nationalen KI-Strategie beschlossen.

"Menschen sollten sich vor anderen Menschen fürchten"

Zwar steckt bereits heute in vielen KI-Anwendungen deutsche Technik, allerdings kaufen momentan vor allem die großen amerikanischen Unternehmen wie Google, Facebook oder Amazon den Markt an KI-Experten leer. Sie setzen die Forscher vor allem für zivile Projekte ein - aber nicht nur: Erst im Juni ließ Google ein Projekt mit dem amerikanischen Verteidigungsministerium auslaufen - nach einem öffentlichen Aufschrei: Das Unternehmen hatte mit seiner Expertise geholfen, Drohnen beizubringen, Objekte automatisch zu erkennen - und damit mögliche Ziele im Kampfeinsatz. Selbst Google-Mitarbeiter protestierten gegen den Deal, zwölf kündigten sogar.

Schmidhuber erinnert allerdings daran, dass autonome Waffen nicht das einzige Schreckensszenario seien: "Menschen sollten sich vor allem vor anderen Menschen fürchten, weniger vor KI." Der KI-Forscher sagt: "Menschen haben die maximale Fähigkeit zur Selbstzerstörung bereits vor mehr als einem halben Jahrhundert erreicht, durch auf Raketen montierte Wasserstoffbomben. Damit lässt sich unsere Zivilisation in wenigen Stunden zerstören, ganz ohne KI."