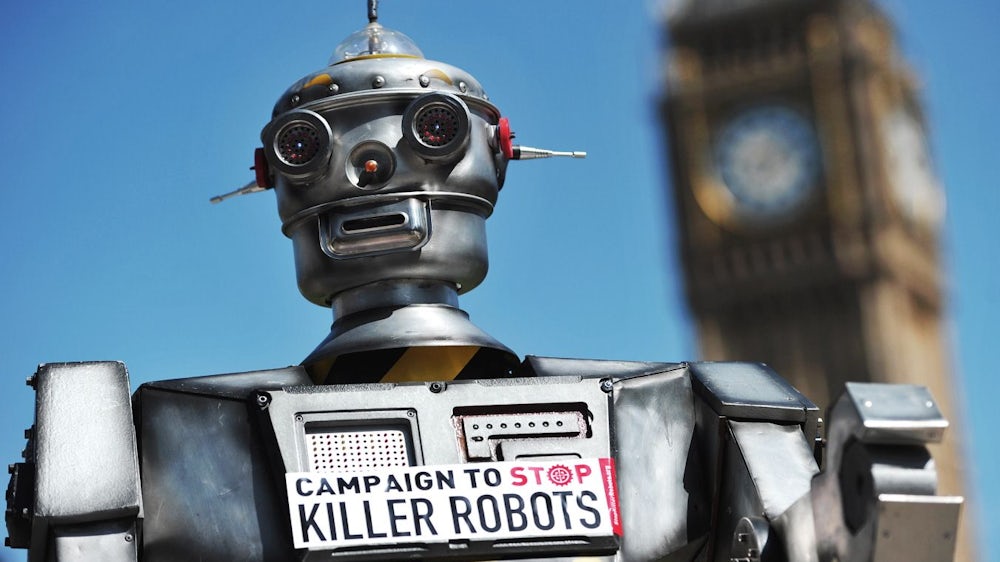

Eine Armee von Killerrobotern, die federnden Schrittes wie eine Horde Tyrannosaurus Rex auf eine Großstadt zustürmen. Maschinen außer Kontrolle, mit rot leuchtenden Elektroaugen, die entfesselt wehrlose Menschen niedermähen. Was seit Jahrzehnten als Motiv in Horror- und Science-Fiction-Filmen von "Terminator" bis "Transformers" auftaucht, könnte durch den technischen Fortschritt in einigen Jahren der Realität zumindest nahekommen. Etliche Länder, unter ihnen die USA, Russland und China, aber auch Großbritannien, Südkorea oder Israel arbeiten an der Entwicklung tödlicher autonomer Waffensysteme, weitere Länder haben zumindest ein Interesse daran.

Autonome Waffensysteme sind an sich nichts Neues: Eine Landmine löst aus, ohne dass ein Kommandeur den Befehl dazu gibt, vor allem aber ohne Unterscheidung, wenn das nötige Gewicht auf den Zündmechanismus ausgeübt wird. Auch die Selbstschussanlagen an der innerdeutschen Grenze feuerten automatisch, einmal scharfgemacht.

Der Unterschied zu modernen Militärrobotern ist, dass diese durch die Fortschritte in der Sensor- und Computertechnik, vor allem bei der Entwicklung künstlicher Intelligenz, künftig komplexe Entscheidungsabläufe auf dem Schlachtfeld übernehmen könnten, ohne dass Menschen noch in diese Prozesse eingreifen.

Tesla-Gründer Elon Musk gibt mit tausenden Forschern das Versprechen, keine autonomen Waffen zu entwickeln. Einer anderer Unterzeichner hält etwas anderes für gefährlicher: den Menschen.

Von der dritten Revolution in der Kriegsführung nach der Erfindung des Schießpulvers und der Atomwaffen ist die Rede - Kritiker solcher Waffensysteme knüpfen daran ihre Warnung und Forderungen nach einer Regulierung oder gar einem Verbot. Zugleich macht sie das für Streitkräfte attraktiv: Technologischer Vorsprung in diesem Bereich soll in den USA dazu beitragen, die militärische Überlegenheit gerade im Vergleich mit Russland und China zu wahren. Andere Staaten, nicht zuletzt China, die stark in künstliche Intelligenz investieren, erhoffen sich, ihren Rückstand zu verkürzen. Unter der Ägide der Vereinten Nationen beraten derzeit in Genf Delegationen aus mehr als 75 Staaten über den Umgang mit diesen futuristischen Waffen.

Schon die Definition ist umstritten: Das Internationale Komitee vom Roten Kreuz (IKRK), das über die Einhaltung des humanitären Völkerrechts wacht, stellt auf die "Autonomie in kritischen Funktionen" ab, also, dass ein Waffensystem Ziele sucht, verfolgt, identifiziert und auswählt und sie ohne Zutun eines Menschen attackiert.

Es gibt bereits heute Luftabwehr- und Nahbereichsverteidigungssysteme, die semiautonom arbeiten - allerdings in eng eingegrenzten Bereichen. Das amerikanische MK-15 Phalanx etwa, auch auf Schiffen der Bundesmarine im Einsatz, soll anfliegende Raketen mit einer Maschinenkanone abwehren, und wird von Menschen nur noch überwacht. Russland verfügt mit dem Pantsir-System über ähnliche Fähigkeiten. Die Armee setzt es in Syrien zur Sicherung ihrer Stützpunkte ein.

Was bedeutet es, wenn Maschinen über den Einsatz tödlicher Gewalt entscheiden?

Geforscht aber wird an unbemannten Kampfjets - eine Fortentwicklung der ferngesteuerten Drohnen, bei denen immer noch ein Mensch den Knopf am Joystick in einem Kommandostand drückt, um Waffen abzufeuern. Mit landgestützten Systemen experimentiert das US-Militär auch bereits seit einiger Zeit: der Crusher ist eine Technologie-Studie eines unbemannten Kampffahrzeugs von 2006, sechs Tonnen schwer, auf drei Achsen, geländegängig, testweise mit einer Maschinenkanone bestückt.

In Genf verhandeln 75 Nationen, um Killerroboter zu regulieren. Eine Einigung ist unrealistisch, weil einige Staaten eigene Interessen verfolgen.

China entwickelt ebenfalls autonome Fahrzeuge für das Militär. Eigenständig agierende Waffensysteme zum Einsatz auf See, unter Wasser oder gar im Weltall wecken ebenfalls Interesse von Streitkräften weltweit, zumal bei menschenleeren Gefechtsfeldern, wo die ethisch-moralischen und rechtlichen Probleme leichter zu überwinden sein könnten.

Die Schlüsselfrage ist, was es bedeutet und welche Folgen es hat, wenn Roboter basierend auf Algorithmen ohne das Zutun eines Menschen Entscheidungen über den Einsatz tödlicher Gewalt treffen. Zwar gibt es bislang keine Rechtsnormen, die den Einsatz solcher Systeme spezifisch regeln. Vertreter der in Genf verhandelnden Staaten seien sich aber im Prinzip einig, dass auch autonome Waffensysteme mit dem humanitären Völkerrecht vereinbar sein müssen, sagte der Vorsitzende der UN-Verhandlungsrunde, der indische Botschafter Amandeep Singh Gill, am Montag in Genf.

Das heißt, dass etwa die zwingend vorgeschriebenen Abwägungen über die Notwendigkeit und die Verhältnismäßigkeit beim Einsatz von Gewalt getroffen werden müssen. Auch zwischen Kombattanten und Zivilisten muss strikt unterschieden werden; Entscheidungen über die Tötung von Menschen oder die Zerstörung von Sachen müssen zudem zurechenbar bleiben, also auf einen Menschen als Verantwortlichen zurückzuführen sein.

Kritiker aus Menschenrechtsorganisationen, aber auch Vertreter vieler Regierungen bezweifeln, dass diese Grundsätze auf Dauer bei autonomen Waffensystemen gewahrt bleiben können. Die Regierungsfraktionen in Berlin haben sich im Koalitionsvertrag darauf verständigt, autonome Waffensysteme abzulehnen, "die der Verfügung des Menschen entzogen sind". Zusammen mit Frankreich hat Deutschland in Genf eine politische Erklärung vorgeschlagen, wonach alle Waffen stets menschlicher Kontrolle unterliegen müssen.

Der aktuelle Stand der Technologie wirft Fragen auf

Aktivisten fordern jedoch, bereits die Entwicklung autonomer Waffensysteme zu verbieten. Denn selbst die besten selbstlernenden Roboter könnten nie ethisch und moralisch handelnde Wesen sein. Die Entscheidung über die Tötung eines Menschen im Krieg an eine Maschine zu delegieren, verletze den Kern der Menschenwürde und entwerte menschliches Leben.

Stattdessen würden Killerroboter es erlauben, "bewaffnete Konflikte in nie gekanntem Ausmaß zu führen und schneller, als Menschen sie begreifen können", wie Hunderte Fachleute für künstliche Intelligenz 2015 in einem offenen Brief warnten. Zu den Unterzeichnern gehörten Tesla-Chef Elon Musk, der Apple-Co-Gründer Steve Wozniak oder der Physiker Stephen Hawking.

Tatsächlich drängen sich beim derzeitigen Stand der Technologie große Fragen auf: Immer wieder gibt es Unfälle etwa mit autonom fahrenden Autos. Die bewegen sich aber in einer relativ geordneten Umgebung: Straßenmarkierungen, Ampeln, Schilder bieten Informationen, es gibt keine Faktoren, die gezielt darauf hinwirken, dass Funktionieren von Sensoren oder Rechnern zu sabotieren. Dagegen herrscht in Gefechtssituationen der "Nebel des Krieges", von dem schon der preußische Militärtheoretiker Carl von Clausewitz schrieb. Die Situation ist ständig im Fluss, die Informationen unvollständig, der Feind darauf bedacht, mit Beschuss, Täuschung, Sabotage den Gegner zu behindern.

Was, wenn der Gegner die Rechner der Roboter hackt?

Gerade das führen Befürworter autonomer Waffen als deren großen Vorteil an: Sie könnten präziser und schneller als Menschen eine Situation erfassen und beurteilen, unbeeindruckt von Stress, Angst und anderen menschlichen Gefühlen, die Fehlentscheidungen begünstigten.

Sie würden sich im Zweifel nicht aus einem Selbsterhaltungstrieb heraus für einen Angriff entscheiden, sondern unbeeindruckt kalkulieren. Sie seien besser geeignet, Menschenleben zu schonen - nicht zuletzt die der eigenen Soldaten. Und die Öffentlichkeit reagiert gegenüber defekten Killerrobotern sicherlich weniger sensibel, als wenn Zinksärge nach Hause geflogen werden.

Was aber, wenn der Gegner nicht Granaten feuert, sondern die Rechner der Roboter hackt? Und kann man wirklich Programmierer und Konstrukteure einer Maschine in gleichem Maße für tödliche Fehler zur Verantwortung ziehen wie einen Kampfjet-piloten, der eine Bombe ausklinkt, fragen die Kritiker. Sie fürchten, dass alle Debatten über einen rechtlichen Rahmen schon bald von der Realität überholt werden und es dann zu spät ist, dem Einsatz von Killerrobotern noch Grenzen zu setzen.