Die Digitalisierung des Alltags schreitet voran. Algorithmen entscheiden, welche Nachrichten wir lesen, welche Partner wir treffen und vielleicht auch, welche Partei wir wählen. Dass automatisierte Systeme und Blackbox-Algorithmen nicht mit dem Transparenzgebot der bürgerlichen Öffentlichkeit vereinbar sind, scheint gewiss.

Der Rechtswissenschaftler Mario Martini schreibt in der Juristen Zeitu ng (JZ), dass der "mathematisch-logische Problembewältigungsmodus" mit seinen inhärenten "Arkan-Formeln" Gefahren für gesellschaftliche Grundwerte berge: "Die Rechtmäßigkeit von Entscheidungen kann nur prüfen, wer die Datengrundlage, Handlungsabfolge und Gewichtung der Entscheidungskriterien kennt und versteht."

Die Forderung, Algorithmen nachvollziehbar und verständlich zu machen, ist auch im Politikbetrieb angekommen. Bundeskanzlerin Angela Merkel sagte bei den Münchner Medientagen 2016: "Ich bin der Meinung, dass Algorithmen transparenter sein müssen, sodass interessierten Bürgern auch bewusst wird, was mit ihrem Medienverhalten und dem anderer passiert." Ein Postulat, worauf sich wohl alle politischen Parteien verständigen können.

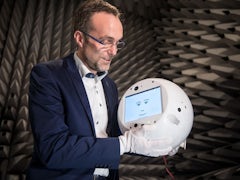

Künstliche Intelligenz stapft nicht in ferner Zukunft als Roboter in unser Leben. Sie ist längst da. Wir müssen uns mit der neuen Technologie vertraut machen - jetzt.

Die Forderung nach mehr Transparenz operiert jedoch mit der Fiktion, dass man Algorithmen nur offenlegen müsse, um sie einer demokratischen Kontrolle zuführen zu können. Die Google-Entwicklerin Rachel Potvin sagte auf einer Konferenz im Silicon Valley, dass der gesamte Google-Software-Komplex - von der Suchmaschine über Gmail bis zum Kartendienst Maps - aus rund zwei Milliarden Zeilen Programmiercode bestehe. Wie will man diesen Krypto-Komplex dekonstruieren?

Das Problem liegt darin, dass die Intransparenz algorithmischer Prozeduren auch Voraussetzung für das Funktionieren der Informationsökonomie ist. Google behauptet, dass bei einer Offenlegung seines Algorithmus Inhalte willkürlich in die oberen Suchranglisten platziert werden könnten und so die informationelle Architektur kollabieren könne. Das ist ein systemimmanenter Widerspruch, bei dem niemand weiß, wie er aufzulösen wäre.

Es droht eine "Herrschaft der Wissenden"

Selbst wenn man die Vorhersage-Algorithmen offenlegte, mit denen in einigen US-Bundesstaaten die Rückfallwahrscheinlichkeit von Straftätern berechnet wird, trüge dies wenig zur Transparenz der Entscheidungsgründe bei. Nicht einmal Richter mit statistischen Grundkenntnissen dürften sie verstehen. Vor allem ändert es nichts am sozialdeterministischen Modus dieser automatisierten Entscheidungsketten: Wenn der Risikoscore höher als 50 liegt, dann ist Haftverlängerung angezeigt. Wenn unter 50, dann Freiheit. Eine für offene Gesellschaften so zentrale Frage wie die nach Freiheit oder Unfreiheit kann nicht mit Gleichungssystemen "gelöst" werden, die gegen Kritik von außen immun sind.

Das führt zum eigentlichen Problem: Algorithmen etablieren eine Herrschaft der Weisen. Denn das Verständnis über die algorithmischen Prozeduren besitzen allein die Programmierer. Ihr Wissen über spezifische Prozesse der Gesellschaft - Google etwa kann die Nachfrage von Wirtschaftsgütern auf einzelne Regionen heruntergebrochen vorhersagen - gerinnt im Zeitalter der Digitalisierung zu Macht. Es ist eine einfache Gleichung: Je algorithmisierter die Gesellschaft ist, desto weniger weiß sie über die zugrunde liegenden Verfahren und desto weniger Einfluss hat sie.

Der Philosoph David Estlund prägte den Begriff der "Epistokratie", einer Regierung der Wissenden. Estlunds Argumentationskette geht so: Unter der Prämisse, dass politische Antworten wahrheitsbasiert sind, wäre es für die Gesellschaft weise, wenn diejenigen Entscheidungen treffen, die am meisten Wissen haben - die Epistokraten.

Es gibt in der politischen Philosophie eine Tradition epistokratischer Ideen, von Platons Philosophenherrschaft über John Stuart Mill, der das Wahlrecht an den Bildungsstand koppeln und Ungebildeten das Wahlrecht entziehen wollte. In den letzten Jahren hat dieses Denken eine Renaissance erlebt, unter anderem mit dem Buch "Gegen Demokratie" des amerikanischen Politikwissenschaftlers Jason Brennan.

Der Clou ist, dass das alte Lamento "Die Wähler wissen nicht, was sie tun", mit dem diese Expertenherrschaft begründet wird, gerade zur Legitimation für algorithmische Systeme wird. Denn Algorithmen wissen im Zweifelsfall besser als wir selbst, welcher Produktkauf am sinnvollsten, welche medizinische Behandlung geboten ist oder welches Wahlprogramm mit unseren Präferenzen korrespondiert. Also delegiert man Entscheidungskompetenzen - und damit Macht. Mit jeder Google-Suche ermächtigen die Nutzer die dahinterstehenden Programmierer.

Nur wenige Wissenschaftler kennen sich mit künstlicher Intelligenz aus. Sie forschten an Elite-Unis und bildeten Studenten aus. Doch dann starten die großen Internetkonzerne ihre Einkaufstour.

Der Soziologe John Danaher entwickelte in Anlehnung an Estlunds Konzept der Epistokratie das theoretische Modell der Algokratie, eine Herrschaft der Algorithmen. In ihr strukturieren soziotechnische Systeme die Entscheidungsprozesse und schränken sie ein. Wie in Estlunds Modell gibt es mit Facebook und Google Akteure, die einen erhöhten epistemischen Zugang zu prozeduralen Verfahren haben.

Nicht nur, indem sie massenhaft Wissen über die Gesellschaft und einzelne Bürger speichern, sondern auch, indem sie Nachrichten mit einem quasistaatlichen Siegel zertifizieren und so erkenntnistheoretische Grundlagen festzurren. Denn ihnen überträgt man, etwa zu differenzieren, was wahr, was Fake News ist. Ex-Google-Chef Eric Schmidt sagte einmal: "Wir wissen, wo du warst. Wir wissen mehr oder weniger, worüber du nachdenkst." Man kann diesen Satz nicht nur als totalitäre Drohung lesen, sondern auch als epistokratischen Machtanspruch.

Googles Computerintelligenzen sind so smart, dass sie die unwissende Nutzerbasis mit gezielten, individualisierten Anreizen lenken können. Wenn dereinst nur noch "gebildete", informierte Softwareagenten am System partizipieren, könnte die Philosophenherrschaft durch eine kybernetische Programmierherrschaft ihr Update erfahren.

Algorithmen sollten für einige Bereiche nicht zugelassen werden

In seinem Werk "Die Macht der Computer und die Ohnmacht der Vernunft" (1977) schreibt der Computerpionier Joseph Weizenbaum: "Der Programmierer ist der Schöpfer von Universen, deren alleiniger Gesetzgeber er selbst ist." Ein Programm zu schreiben, bedeute, einer Welt Gesetze zu geben. Über diese algorithmische Regulierung ist es möglich, die Verfahrensregeln liberaler Demokratien zu überschreiben und eine großtechnische Manipulation ins Werk zu setzen.

Facebook hat 2014 in einem riesigen sozialen Experiment den Newsfeed von fast 700 000 Nutzern manipuliert und jüngst in Ländern wie Serbien und Sri Lanka den Newsfeed in zwei Nachrichtenströme unterteilt, was den Journalisten Stevan Dojcinovic in der New York Times zu dem empörten Aufruf veranlasste: "Hey, Mark Zuckerberg, meine Demokratie ist nicht dein Labor." Doch genau darum geht es: Für Facebook, Google und Co. ist die Demokratie ein Laborversuch, in der man Bürger als Probanden instrumentalisiert und sie unter Ausnutzung psychologischer Schwächen lenkt, ohne das Versuchsdesign publik zu machen.

Die Forderung nach einer Algorithmenkontrolle zielt daher am eigentlichen Problem vorbei: Es geht nicht darum, Algorithmen transparent zu machen, sondern die pseudowissenschaftlichen Modelle generell infrage zu stellen und kritisch zu prüfen, wieweit das Soziale überhaupt mit mathematischen Methoden organisiert werden kann. Der Kulturtheoretiker Felix Stalder warnt, dass die Modelle irgendwann der Welt vorschreiben, wie sie zu sein hat. Die Gefahr liegt also darin, dass mathematische Werte irgendwann kulturelle oder politische definieren. Um das zu verhindern, wäre es ratsam, Algorithmen nicht offenzulegen, sondern für nicht mathematisierbare Prozesse wie die Strafjustiz erst gar nicht zuzulassen.