Wer heutzutage über Daten oder "Big Data" spricht, verwendet dabei gerne Metaphern. Mal sind Daten das "neue Öl", wie Bundeskanzlerin Angela Merkel sie auf der Digitalklausur der Regierung Anfang des Jahres nennt. Mal führen sie zur "Revolution, die unser Leben verändern wird". Skeptischere Zeitgenossen wie die Harvard-Professorin Shoshana Zuboff halten sie in der digitalen Gesellschaft für einen Machtfaktor. Sie würden den Weg in den Überwachungskapitalismus ebnen.

Unstreitig ist jedoch, dass derzeit so viele Daten wie noch nie erzeugt, gesammelt und analysiert werden. Sei es um Anwendungen für künstliche Intelligenz und maschinelles Lernen zu füttern, sei es, weil die milliardenschweren Silicon-Valley-Konzerne wie Facebook und Google noch passgenauere Werbung an ihre Kunden ausspielen wollen. Unternehmen sammeln viel, und sie können es, weil Sensoren oder auch Nutzer sie ihnen oft (mehr oder weniger) freiwillig liefern. Allerdings wissen die Datensammler nicht immer, ob sie die Informationen auch jemals brauchen können werden.

Aber aus Sorge, dass ihnen etwas entgeht, greifen sie immer zu, ob es sich nun um die Haarfarbe des Nutzers handelt oder in welcher Sekunde er morgens das Licht im Bad anschaltet. Vielleicht lassen sich diese Informationen doch noch zu Geld machen - wenn nicht heute, dann vielleicht morgen.

Eine Erhebung des US-Netzwerkspezialisten Cisco kam zum Ergebnis, dass eine Stadt mit einer Million Einwohnern im Jahr 2020 bereits 200 Millionen Gigabyte Daten am Tag erzeugt - durch smarte und vernetzte Häuser, Autos und Wettersensoren. Tatsächlich weiterverwendet werden aber in den meisten Bereichen gerade einmal 0,1 Prozent davon. Das heißt, bei den Big-Data-Sammelorgien entstehen Unmengen an Daten, die erst mal ungenutzt herumliegen: Und sie werden im schlimmsten Fall zu "Dark Data", also dunklen Daten.

Björn Schembera beschäftigt sich am Höchstleistungsrechenzentrum in Stuttgart (HLRS) mit diesen dunklen Daten. Er versucht, Licht in das bislang wenig beachtete Problemfeld zu bringen. Für den Informatiker sind Daten dann dunkel, wenn sie nur eingeschränkt sichtbar und damit nutzbar sind. Wenn nicht auf sie zugegriffen werden kann oder sie nicht ausreichend beschrieben sind, obwohl sie einmal mit technischem, wissenschaftlichem und finanziellem Aufwand erstellt wurden, sagt Schembera.

Für die Diskette, auf der man einst seine Magisterarbeit speicherte, gibt es kein Laufwerk mehr

Jeder kennt die vergessenen USB-Sticks in der Schublade, voll mit alten Fotos oder anderen Daten. Und hat man seine Magisterarbeit einst auf einer Diskette gespeichert, gibt es mittlerweile gar kein Laufwerk mehr am Rechner, um sie noch einmal durchlesen zu können. Auch auf alte E-Mail-Accounts lässt es sich oft nicht mehr zugreifen, entweder weil es die Anbieter nicht mehr gibt oder man irgendwann sein Passwort vergessen hat und der Account nach Jahren an Inaktivität gesperrt oder gelöscht wurde. Die Daten, die man dort hinterlassen hat, sind aber damit nicht automatisch mit verschwunden.

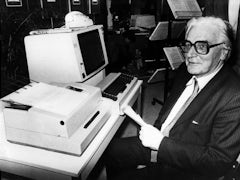

Die ersten Rechner wurden schon in den 1820er-Jahren entworfen, den ersten Digitalrechner schuf 1941 ein Berliner. Nach 1960 war der Fortschritt dann rasant.

Was man privat noch unter Pech oder technischen Fortschritt verbuchen kann, hat für Forschungseinrichtungen und Firmen ganz andere Dimensionen. Eine Studie des Datenauswerters Splunk von 2019 kommt zu dem Ergebnis, dass 55 Prozent der Daten eines Unternehmens dunkel sind. Das heißt, Unternehmen wissen gar nicht, dass diese existieren oder wo und wie sie sie finden, aufbereiten, analysieren und nutzen können. Die Analysten von IDC prophezeien, dass die Menge der Daten weltweit von heute 33 auf 175 Zetabyte steigen wird. Mehr als die Hälfte davon werden Dark Data sein.

Das Speichern der immensen Mengen ist auch ein Kostenfaktor, nicht nur die Speichermedien müssen bezahlt werden, es entstehen auch Stromkosten. Und wenn zur Sicherheit immer noch Kopien angefertigt werden, steigen die Kosten noch weiter. Und sie verursachen riesige Mengen an CO₂. Nach einer Studie des Software-Unternehmens Veritas, das sich auf Datenmanagement spezialisiert hat, führen dunkle Daten im Jahr 2020 zu einem Ausstoß von 6,4 Millionen Tonnen CO₂, weil Unmengen an Datenmüll und sinnlos archivierten Daten auf Rechenzentren abgeladen werden.

Auch rechtlich können dunkle Daten Probleme bereiten. So regelt die Datenschutzgrundverordnung (DSGVO) eindeutig, dass personenbezogene Daten sofort gelöscht werden müssen, wenn diese für "die Zwecke, für die sie erhoben oder auf sonstige Weise verarbeitet wurden, nicht mehr notwendig" sind. Aber wer ist zuständig für sogenannte verwaiste Daten, also Daten, auf die niemand mehr zugreift? Wem gehören diese Daten, wer ist verantwortlich und traut sich eventuell sogar, diese zu löschen?

Technische Lösungen allein werden dem Problem nicht gerecht

Und was passiert, wenn niemand weiß, dass es diese Daten überhaupt gibt? Nicht auffindbare Daten sind Daten, die nicht nur bei wissenschaftlichen Studien fehlen, um die richtigen Schlüsse zu ziehen. Auch wenn klar ist, dass es kein 100-prozentiges Wissen gibt. Der Londoner Statistikprofessor David Hand fasst in seinem neuen Buch "Dark Data - Why what you don't know matters", den Begriff der dunklen Daten als Daten, die man nicht hat. Sie ähneln also dem Begriff der Dunkelziffer.

Das können Daten sein, von denen man nicht weiß, dass man sie nicht hat, wie fehlende Antworten auf einem Formular oder aber auch Daten, von denen man nicht weiß, dass man sie nicht hat, wie die unzufriedenen Kunden, die sich nicht beschwert haben. Die datengetriebene Gesellschaft beruhe auf der Annahme, dass es kaum fehlende, verzerrte oder ungenaue Daten gibt oder dass kleine Mengen davon kein Problem sind. Das sei aber falsch, diese fehlenden Werte könnten entscheidend sein. Für das HLRS in Stuttgart hat Björn Schembera in einer Forschungsarbeit Konzepte erarbeitet, wie mit dem Problem der dunklen Daten umgegangen werden soll, wie sie vermieden oder wenigstens reduziert werden können. Dort steht derzeit der schnellste Supercomputer Europas namens Hawk. Hawk hat eine maximale Leistung von 26 Petaflops, kann also 26 Billiarden (eine Billiarde = 10¹⁵) Gleitkomma-Berechnungen pro Sekunde ausführen. Das HLRS versteht sich auch als Dienstleister für die Automobilindustrie. Durch deren computergestützte Projekte, Simulationen und die Forschungsarbeiten der Wissenschaftlerinnen und Wissenschaftler entstehen am HLRS sehr viele Daten. Nach Angaben von Schembera werden dort derzeit circa 22 Petabytes an Daten gehalten, davon sind drei Prozent dunkle Daten, das sind 580 Terabytes.

Schembera schlägt für ein erfolgreiches Datenmanagement zum einen technische Lösungen vor, wie zum Beispiel eine automatisierte Beschriftung mit Metadaten, die auch von Dritten verstanden werden. Außerdem sollten sie an einem Ort gespeichert werden, der auch durchsucht werden kann. Zum anderen sind aber auch organisatorische Lösungen notwendig: So sollte es in Forschungseinrichtungen, und das lässt sich auch auf Unternehmen übertragen, einen "Data Officer" geben.

Also ein Mensch und kein Algorithmus, der Entscheidungen trifft, Fristen festlegt wie lange bestimmte Daten aufbewahrt werden, also zum Beispiel, wie lange Nutzerinnen und Nutzer inaktiv sein müssen, bis ein Account stillgelegt wird. Und diese Person darf und soll die ungenutzten Daten schließlich auch löschen. Was Müll ist, muss nicht ewig aufbewahrt werden.