Der Philosoph Ludwig Wittgenstein ist wieder erstaunlich aktuell. Er wird in Science-Fiction-Filmen zitiert und auf Kongressen und Workshops zu künstlicher Intelligenz zurate gezogen. Warum aber Wittgenstein? Um diese Frage beantworten zu können, muss man den Blick zurück in die Mitte des zwanzigsten Jahrhunderts werfen, als fünf innovative Forschungsprogramme fast gleichzeitig entwickelt wurden.

Zunächst spielte die von Norbert Wiener 1948 projektierte Kybernetik eine wegweisende Rolle. Sie befasste sich mit Regelungs- und Steuerungsvorgängen in komplexen Systemen und erklärte technische Maschinen, lebende Tierautomaten und menschliche Wesen gleichermaßen zu ihren Forschungsobjekten. Es sollte allein darauf ankommen, die abstrakten Mechanismen freizulegen, die für das berechenbare Funktionieren dieser Systeme verantwortlich sind.

Das kybernetische Programm verknüpfte sich schon früh mit den logischen und zahlentheoretischen Arbeiten Alan Turings, dessen universale Rechenmaschine die Unterschiede zwischen Maschinen und menschlichen Rechnern vergleichgültigte. Das führte Turing zu jener Theorie, die er ebenfalls 1948 zum ersten Mal veröffentlichte: Es gibt intelligente Maschinen, die denken können. Um verschiedene Einwände gegen diese "häretische" Idee zu entkräften, schlug er 1950 ein Imitationsspiel vor, in dem eine Turing-Maschine intellektuelle Fähigkeiten zu simulieren versuchte. Wäre dabei kein Unterschied zwischen Mensch und Maschine festzustellen, so müsse man anerkennen, dass auch die Maschine denken könne.

Bei künstlicher Intelligenz hält die Autorin Manuela Lenzen wenig von Ängsten und übertriebenen Erwartungen. Ihr Buch sollte man schnell lesen - weil es bald überholt sein wird.

Aus dem Geist der Kybernetik und der Automatentheorie entsprang Mitte der Fünfzigerjahre das Forschungsprogramm der künstlichen Intelligenz, das 1956 auf der Dartmouth-Konferenz vorgestellt wurde. Dabei wies der "Intelligenz"-Aspekt auf kognitive Modellierung hin, während die Perspektive des "Künstlichen" hervorhob, dass man vor allem an Hardware- und Software-Konfigurationen interessiert war, die in Rechenmaschinen implementiert werden können. Während sich die KI-Forscher auf Denkprozesse konzentrierten, begann der junge Linguist Noam Chomsky an seinem Projekt einer generativen Grammatik zu arbeiten. 1957 erschien sein revolutionäres Buch "Syntactic Structures", in dem er die Grundzüge eines mathematisierten grammatischen Regelsystems entwarf, das alle "natürlichen" Sätze einer Sprache als Strukturgebilde zu modellieren oder generieren vermag.

Und schließlich wurde zur gleichen Zeit auch mit dem Gedanken Ernst gemacht, dass bei biologischen Lebensprozessen eine Nukleinsäure des Desoxyribose-Typus die grundlegende Rolle spielt. 1953 bastelten James Watson und Francis Crick ihr DNS-Modell zusammen, das zu schön war, um nicht wahr zu sein. Die gewundene Doppelhelix wurde zum charismatischen Symbol der modernen Biowissenschaften.

Angesichts dieser wissenschaftlichen Revolutionen gewinnt die alte Frage nach dem Wesen des Menschen ein neues Profil. Sie kann nicht mehr einfach durch eine humanistische Selbstvergewisserung beantwortet werden, sondern muss die epochale Wende zu Modellen, die geistige, sprachliche und biologische Prozesse simulieren, ernst nehmen. Gibt es noch gut begründbare Verfahren, die es erlauben, zwischen der humanen Natürlichkeit des Menschen und seiner künstlichen Simulierbarkeit verlässlich zu unterscheiden?

Können Maschinen "seelische" Eigenschaften bekommen?

Die Wissenschaften selbst lassen sich durch diese Fragen nicht irritieren oder von ihrem Weg abbringen. Sie sind bestrebt, ihre Modelle zu perfektionieren und ihren Untersuchungsobjekten immer besser anzugleichen. Innerhalb dieses Prozesses werden kritische Stimmen kaum noch gehört. Das erhellt, warum sich das Problem der Simulation in künstlerische Imaginationen und philosophische Gedankenexperimente verlagert hat, die mit dem Eröffnungszug beginnen: Man stelle sich einmal vor ... - Dass sie sich auch verbinden lassen, dokumentieren Filme wie "Blade Runner" von Ridley Scott (1982) oder "Ex Machina" (2015) von Alex Garland.

Nicht zufällig hieß der Replikantenjäger, der in "Blade Runner" echte von simulierten Menschen unterscheiden sollte, Rick Deckard, wie der Held in Philip K. Dicks Roman "Do Androids Dream of Electric Sheep" (1968), der literarischen Vorlage des Films. Sein Name sollte an René Descartes erinnern, der sich vorgestellt hatte, dass der menschliche Körper nichts anderes sei als eine Maschine. Den kreativen Sprachgebrauch des Menschen und seine flexible, in allen möglichen Problemsituationen einsetzbare Vernunft spaltete er als seelische Phänomene vom Körper ab.

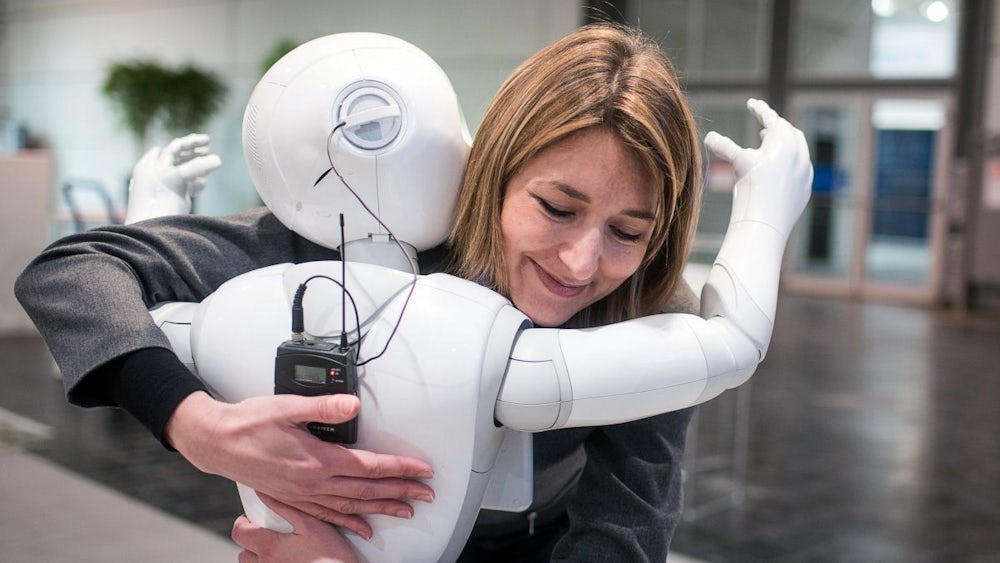

Die Entwicklung von KI und generativen Sprachmodellen hat diese cartesianische Unterscheidung geschwächt. Deshalb war es ein schöner Einfall, dass in "Ex Machina" Ludwig Wittgenstein zitiert wurde, der dem cartesianischen Problem eine neue Wendung gab. In diesem Film ging es um die Frage, ob ein intelligentes KI-System, das mit einer Chomsky-Sprachkompetenz programmiert und biotechnisch einer schönen jungen Frau nachgebildet war, jene "seelischen" Eigenschaften besitzen würde, die Descartes dem Menschen vorbehalten hatte. Ein ausgezeichneter Programmierer sollte, nach dem Vorbild des Turing-Tests, feststellen, ob das KI-System Wahrnehmungserlebnisse, Gefühle und Stimmungen hatte oder sie nur vorspiegelte, ausgestattet mit einem reichhaltigen Repertoire von mimischen Ausdrucksmöglichkeiten.

Das hochgerüstete Technologieunternehmen in "Ex Machina" hieß "Bluebook", benannt nach seiner philosophischen Betrachtung, deren Manuskript Wittgenstein in einem blauen Karton binden ließ. Wittgensteins Name wurde erwähnt, und an einer Wand hing das Porträt, das Gustav Klimt von Wittgensteins Schwester Margarethe Stonborough-Wittgenstein gemalt hatte. Auch das war kein Zufall. Schon seit einigen Jahren spielen die philosophischen Untersuchungen Wittgensteins eine wichtige Rolle, wenn es um die Möglichkeiten und Grenzen der technischen Simulationen mentaler Ereignisse geht. Wittgenstein hat keine Theorie entwickelt, die eine systematisch begründete Lösung des Problems zu bieten hätte. Stattdessen hat er die Aufmerksamkeit für die Problemsituation geschärft, in die man gerät, wenn man mentale Prozesse - Denken, Verstehen, Meinen, Empfinden, Wahrnehmen oder Erinnern - wie Dinge oder Sachverhalte beobachten, benennen und erklären will.

"Nur von dem, was sich benimmt wie ein Mensch, kann man sagen, dass es Schmerzen hat"

Sein "Blaues Buch", mit dem 1933/34 seine Spätphilosophie begann, verdeutlichte den "geistigen Krampf", der verursacht wird, wenn wir Wesensfragen stellen wie "Was ist Schmerz?", "Was ist Denken?", "Was ist Meinen?" "Wir spüren, dass wir auf nichts zeigen können, um sie zu beantworten, und dass wir gleichwohl auf etwas zeigen sollten. (Wir haben es hier mit einer der großen Quellen philosophischer Verwirrung zu tun: ein Substantiv lässt uns nach einem Ding suchen, das ihm entspricht.)" Aus diesem Wirrwarr kann uns, so Wittgenstein, auch kein "Modellgeist" befreien, an dessen Funktionieren wir aufzeigen könnten, was wir tun, wenn wir Schmerzen empfinden, einen Gedanken verstehen oder den Besuch eines Freundes erwarten. Wir müssen den Blick auf das gesellschaftliche "Sprachspiel" richten, auf das Ganze von Sprache und Tätigkeiten, mit denen sie verwoben ist, wie es uns alltäglich vertraut ist. Gefordert ist ein Sehen, das die reiche und bunte Mannigfaltigkeit des menschlichen Ausdrucks, Handelns und Sprachgebrauchs aufmerksam und differenziert zur Kenntnis nimmt.

Mit diesem neuen Blick war Wittgenstein immer klarer geworden, dass seelische Prädikate wie "Schmerz" oder "Denken" nur in den allerseltensten Fällen als Begriffe verwendet werden, um etwas zu benennen. In der Regel drückt ihr Gebrauch aus, dass die Teilnehmer eines gesellschaftlichen Sprachspiels sich gegenseitig als Mitmenschen wahrnehmen und anerkennen. Man sieht es an ihren Umgangsformen und ihren sprachlichen, mimischen und gestischen Äußerungen.

Das Sprachspiel seelischer Ereignisse zeigt uns, dass wir empfindungsfähige und mitfühlende Menschen sind, keine Steine oder Käfer, keine Puppen oder Automaten, keine Androiden oder Replikanten. "Nur von dem, was sich benimmt wie ein Mensch, kann man sagen, dass es Schmerzen hat." Und nur von demjenigen, der zeigt, dass er zu Mitgefühl oder Mitleid fähig ist, kann man sagen, dass er ein Mensch ist. Diese Überlegungen, die Wittgenstein bis kurz vor seinem Tod am 29. April 1951 anstellte, wurden 1953 postum in seinen "Philosophischen Untersuchungen" veröffentlicht. Sie kreisten um die fundamentale Frage: "Was ist der Mensch als beseelter Körper?" Er stellte diese Frage nicht als Biologe oder Intelligenzforscher, Sprachwissenschaftler oder Logiker. Er war Philosoph, wobei er sich schon früh darüber klar geworden war, dass er dabei in Gefahr war, im Wirrwarr der komplizierten Probleme geistig zu verkrampfen.

Das betraf auch das Problem der Unterscheidung von Mensch und Maschine. Als Wittgenstein sich in seinen letzten Lebensjahren fragte, für wen etwa die auf einen Freund bezogene Feststellung "Er ist kein Automat!" eine sinnvolle Mitteilung sein könnte, wird er an Norbert Wiener und Alan Turing gedacht haben, der gerade "intelligente Maschinen" als Mechanismen vorgestellt hatte, die wie Menschen denken würden. Und er wird sich dabei an die Gespräche erinnert haben, die er mit Turing geführt hatte, als er 1939 bei ihm einige Seminare über die Grundlagen der Mathematik besuchte. Den Siegeszug der künstlichen Intelligenz, der generativen Grammatik und der Gentechnologie hat Wittgenstein nicht mehr erlebt. Aber er hat die Probleme gesehen und zu klären versucht, die unseren Verstand unauflösbar verknoten würden, wenn wir nicht mehr unterscheiden könnten, was echt oder simuliert ist, menschliche Wirklichkeit oder maschinenartiges Modell, tatsächlich der Fall oder bloß Fake.