Er gilt als einer der weltweit führenden Köpfe zum Thema künstliche Intelligenz und ist geistiger Vater des humanoiden Roboters "Roboy": Rolf Pfeifer war Gründer und Leiter des "Labors für Künstliche Intelligenz" an der Universität Zürich. Seit seiner Emeritierung im Juli 2014 forscht er an der Universität Ōsaka und der Jiaotong-Universität Shanghai. Der 68-jährige "Guru der Robotik" beschäftigt sich mit Fragestellungen rund um das künstliche Leben, mit der Biorobotik, mit Emotionen und der Lehre von der Struktur und Form von Organismen (Morphologie). Im Semester 2003/2004 hielt er an der Universität Tokio die erste globale Video-Vorlesungsreihe der Welt.

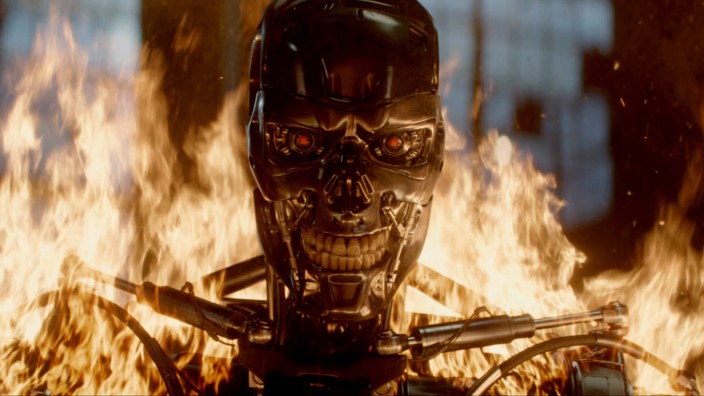

SZ: Herr Pfeifer, kann es sein, dass es irgendwann Roboter geben wird, die so wie "Terminatoren" blitzschnell und situationsbedingt Entscheidungen treffen können?

Rolf Pfeifer: Erwarten Sie von mir keine Zukunftsprognose. Aber betrachten wir zunächst mal einen Roboter, der nicht "Terminator"-ähnlich ist, zum Beispiel selbstfahrende Autos. Die fahren im Augenblick zwar noch sehr langsam, aber das ist keine Sache, die erst in 20 Jahren kommen wird, das werden wir in den nächsten zwei, drei Jahren haben. So ein Auto beispielsweise muss in Verkehrssituationen ebenfalls sehr schnell Entscheidungen treffen.

Die Entscheidungen, die ein Roboter-Auto treffen muss, sind sehr übersichtlich. Im Grunde geht es doch lediglich darum, Kollisionen zu vermeiden. Aber es muss keine Situation erkannt werden, die vorher vielleicht so noch nie da war.

Da bin ich mir nicht so sicher. Ich glaube, es werden sich durchaus profunde ethische Fragen stellen. Wenn man sich zum Beispiel eine Situation vorstellt, bei der ein Kind mit dem Ball auf die Straße rennt, und das Auto ist zu schnell um noch rechtzeitig zu bremsen, und im weiteren Umfeld befinden sich weitere Verkehrsteilnehmer. Unter Umständen lautet die zu treffende Entscheidung dann, welches Menschenleben geopfert wird, um insgesamt den geringsten Schaden anzurichten. Ich glaube nicht, dass es dafür eine gute Lösung gibt. Trivial ist das auf jeden Fall nicht.

Sie werfen einen interessanten ethischen Aspekt auf. Aber wenn wir die Sache vom technischen Standpunkt aus betrachten: Bedeutet die Existenz autonom fahrender Autos, dass es irgendwann einmal künstliche Intelligenz in der Form geben wird, wie sie in den "Terminator"-Filmen gezeigt wird?

Als Wissenschaftler würde ich nie "nie" sagen. Aber als Ingenieur weiß ich natürlich, dass die Entscheidungen, die ein Roboter-Auto treffen muss, viel eingeschränkter sind als bei einem Roboter, der sich in der Gesellschaft bewegt. Das Auto kann im Prinzip bremsen, beschleunigen, es kann nach links oder nach rechts fahren, sonst kann es nichts. Es hat also einen extrem eingeschränkten Handlungsspielraum, während ein Roboter einen sehr viel größeren Handlungsspielraum hat. Das macht die Sache komplex.

Ist die Entwicklung von Robotern mit viel weitreichenderen Fähigkeiten überhaupt sinnvoll?

Das kann keiner ausschließen, aber den Weg dorthin halte ich für unwahrscheinlich. Denn unsere Hypothese, die von immer mehr Wissenschaftlern getragen wird, lautet, dass es für die menschlichen Formen künstlicher Intelligenz eines Körpers bedarf. Wir sprechen hier vom Konzept der "Embodied Intelligence", die sich ja auch evolutionsgeschichtlich so entwickelt hat. Das heißt: Unsere Kognition war immer Teil eines ganzen Organismus. Dieser Organismus prägt die Art des Denkens, die Art, wie wir handeln und auch die Art unserer ethischen Prinzipien, wie wir als Menschen miteinander umgehen. Das ganzheitlich hinzubekommen, ist eine extrem komplizierte und teure Aufgabe. Und der wirtschaftliche Nutzen dabei ist zunächst nicht erkennbar.

"Mächtig sein zu wollen, hat viel mit Emotionen zu tun"

"Geist und Körper" würden also auch bei Maschinen zusammengehören, wenn sie uns ähneln sollen?

Genau. Wenn jemand zum Beispiel Durst hat, dann ist es für mich eine ganz wesentliche Intelligenzfunktion, zu wissen, was Durst ist. Zu wissen, was zu tun ist, wenn jemand am Verdursten ist.

Könnte man das nicht einprogrammieren, wenn ein gewisses Maß an Dehydrierung überschritten wird?

Ich kann dem Roboter ein paar Regeln einfüttern, dass er so tut, als ob er Durst hätte. Aber die Frage ist, ob das dann zählt? Denn man muss selbst erlebt haben, wie es sich anfühlt, wenn man wirklich Durst hat, und wie es sich anfühlt, wenn man den Durst löschen kann. Für mich gehört das Mitfühlen zur menschlichen Intelligenz.

Aber vielleicht hat man in 100 Jahren ja die Sensomotorik dafür, selbst das zu programmieren.

Vielleicht. Aber die entscheidende Frage für mich lautet, ob das ökonomisch Sinn machen würde. Denn, wenn man das weiterdenkt, muss man Roboter dem Menschen nachempfinden. Und ich bin nicht überzeugt davon, dass das etwas bringen würde.

Warum nicht?

Wir Menschen können unglaublich viele Dinge. Wir können rauchen, wir können schwatzen, wir können gehen, wir können Flugzeuge bauen, wir haben komplexe gesellschaftliche Strukturen, wir haben Computer, Mobiltelefone ...

... und Roboter ...

... genau, die auch. Es ist unglaublich, was wir Menschen alles geleistet haben. Und doch haben wir für die meisten dieser Tätigkeiten Maschinen, die diese schneller, besser, billiger, präziser und ohne Ermüdungserscheinungen verrichten können. Vor diesem Hintergrund stellt sich die Frage, ob es sinnvoll ist, die Kopie eines Menschen zu erstellen, die zwar alles kann, aber alles nur mehr schlecht als recht. Oder ob es in wirtschaftlicher Hinsicht nicht viel sinnvoller ist, hochspezialisierte Maschinen zu bauen, die zwar nur eine Fähigkeit haben, aber diese viel besser erledigen als der Mensch.

Da ist wohl Letzteres wahrscheinlicher, zumindest deutet bei der bisherigen Entwicklung alles darauf hin.

So sehe ich das auch. Wobei ich im selben Atemzug betone, dass der Versuch, die menschliche Intelligenz anzunähern, als Forschungsaufgabe sehr lohnend ist. Denn wir lernen extrem viel. Nicht nur darüber, wie man Roboter baut, sondern auch über die menschliche Intelligenz.

Ökonomie hat viel mit Macht zu tun. Das eigentliche Ziel von Skynet, der Maschine, die in den "Terminator"-Filmen alles steuert, ist der Machterhalt. Ist das ein realistisches Konzept: eine Form der künstlichen Intelligenz, die die Macht für sich haben will?

Mächtig sein zu wollen, hat viel mit Emotionen zu tun. Machtausübung ist also etwas zutiefst Menschliches. Wenn man ein Gerät wollte, das tatsächlich einen eigenen Machtinstinkt entwickelt, stünde man wieder vor dem Problem, eine möglichst menschenähnliche Maschine zu bauen, die vollkommen selbständig den Anspruch entwickelt, die Menschen zu unterjochen, wie das im Film gezeigt wird. Und das ist ja ein sehr beängstigendes Szenario.

Der Gruseleffekt, den die "Terminator"-Filme erzielen, beruht ja aber genau auf der Vorstellung, dass die Menschen ein Gerät gebaut haben, das sich gegen sie wendet.

Ja, sicher. Aber das heißt ja noch lange nicht, dass man sich davor tatsächlich fürchten muss. Erstens spricht wie gesagt die Ökonomie gegen das Vorhaben, einen möglichst menschenähnlichen Roboter zu entwickeln, obwohl das Forschungsziel natürlich ein äußerst spannendes wäre und weitreichende wissenschaftliche Einsichten verspräche. Zudem rührt viel von dem, was der Mensch heute ist, von seiner biologischen Herkunft und vom Kampf ums Überleben her. Und da stellt sich die Frage, ob sich das in einem künstlichen Wesen autonom entwickeln kann, wenn die biologischen Notwendigkeiten ganz andere sind.

Rolf Pfeifer, bekannt als "Guru der Robotik".

(Foto: Osaka University)Wenn die Roboter Babys kriegen

Terminatoren müssen wir also eher nicht fürchten. Sehen Sie andere Gefahren, die wir durch die Entwicklung künstlicher Intelligenz heraufbeschwören?

Es gibt ein weiteres klassisches Horrorszenario: Einige Leute stellen sich heute die bange Frage, ob sich die Roboter selber reproduzieren werden. Dabei merken sie gar nicht, dass sich Technologie längst selbst reproduziert.

Eine Muttermaschine gebärt Baby-Maschinen? Das müssen sie erklären.

Die reproduktiven Mechanismen sind natürlich andere als die biologischen. Die Roboter, oder sie können auch Autos nehmen, einen BMW etwa, zwingen die Menschen gewissermaßen dazu, sie zu reproduzieren. Die guten Autos verkaufen sich einfach besser als die schlechten.

Aber die Maschinen zwingen den Menschen doch nicht zum Bau immer weiterer Modelle.

Können wir denn wirklich noch den Stecker ziehen? Es wäre ja nicht "der eine Stecker", sondern Milliarden von Steckern. Nein, das können wir nicht. Denn es würde alles zusammenbrechen: die Börse, das Finanzsystem, das ganze ökonomische System, die ganze Logistik. Es würde Hungersnöte geben, Katastrophen. Die Maschinen, die Roboter und Computer zwingen uns, sie am Leben zu erhalten, sie ständig upzudaten und sie funktionstüchtig zu halten.

Und das alles, ohne dass ein Machtanspruch dahinter steht. Raffiniert, diese Maschinen!

Ob man den Maschinen raffinierte oder sogar böswillige Intentionen unterstellen will, ist eine rein philosophische Frage. Aber de facto läuft hier ein evolutionärer Prozess ab, der der biologischen Evolution gar nicht so unähnlich ist: Diejenigen, die besser sind, zwingen einen, laufend noch größere Fabriken zu bauen.