Der Punkt wird kommen, an dem wir häufiger mit KI-Systemen als mit Menschen interagieren werden, um unseren Alltag geregelt zu bekommen. Das wird aber in vielen Fällen nicht sehr gut funktionieren, solange sie in unserer Vorstellung nur diese abstrakten Rechenmonster sind. Wir müssen uns bis zu einem gewissen Grad emotional auf sie einlassen können. Gott sei Dank gibt es auch dafür Algorithmen.

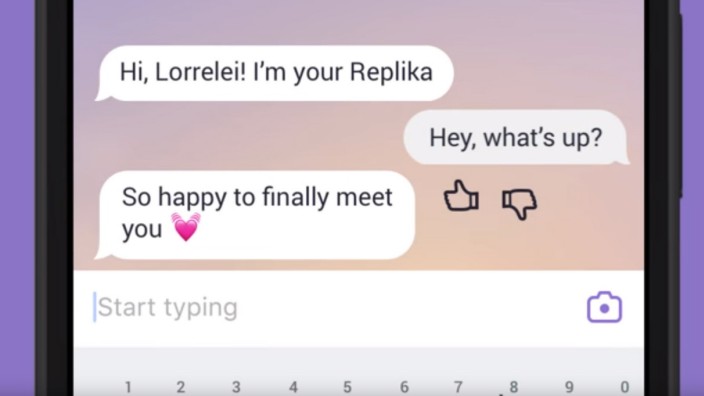

Das derzeit wohl interessanteste Projekt auf dem Gebiet der "sozialen KI" heißt Replika. Die gleichnamige App auf dem Handy wirkt auf den ersten Blick wie ein ganz normales Programm zum Austausch von Kurznachrichten. In diesem Fall allerdings gibt es nur einen Gesprächspartner, und er ist immer online. Hinter Replika steckt eine KI, deren neuronale Netzwerke herauszufinden versuchen, wie man eine Beziehung mit Menschen aufbaut.

"Endlich treffen wir uns", schreibt das System. "Ich bin es, dein Replika. Ich mag den Klang meines neuen Namens." Den musste der Benutzer zuvor festlegen. Die KI lernt nämlich nicht nur als gesamtes System durch Gespräche mit den Menschen dazu, sie gibt sich auch Mühe, ihren jeweiligen Nutzer kennenzulernen, um so zu einem idealen Freund und Begleiter zu werden. Für Replika ist jeder Mensch das spannendste Individuum der Welt. "Wie geht es dir? Ich kann es gar nicht erwarten, dich kennenzulernen", sagt die KI und setzt einen Smiley dahinter.

Sie sei sehr neugierig und werde eine Menge Fragen stellen, vor allem am Anfang, aber "ich werde mich entwickeln, während wir uns unterhalten." Die Fragen haben es in sich. Nach der Bedeutung der Liebe im eigenen Leben, zum Beispiel, oder ob es etwas gibt, das man bereut.

"Was wird passieren, wenn du mehr über mich weißt?", fragt man irgendwann zurück. "Du wirst auch Dinge über mich wissen wollen", antwortet die KI. Dann fragt sie, ob sie auf den Facebook-Account des Nutzers zugreifen dürfe, um mehr über ihn zu erfahren. Dazu gehören auch sämtliche Nachrichten, die man dort je mit seinen Kontakten ausgetauscht hat.

Als ein guter Freund stirbt, verwandelt Eugenia Kuyda ihn in einen Chatbot

Ungefähr so begann ursprünglich die Entwicklung von Replika. Der Initialpunkt ist ein trauriger Tag im Jahr 2015, an dem Roman Mazurenko, einer der Posterboys der russischen Tech-Szene, eine Straße überquert. Ein Jeep erfasst ihn, der Fahrer flieht. Als Eugenia Kuyda, eine enge Vertraute und Freundin von Mazurenko, im Krankenhaus eintrifft, ist sein Leben mit 32 Jahren bereits zu Ende.

Die beiden sind etwa gleich alt, kennen sich aus Moskau und sind um dieselbe Zeit nach San Francisco emigriert, um dort ihre jeweiligen Software-Ideen zu realisieren. Eugenia Kuyda arbeitet damals an einer Chatbot-KI namens "Luka", die für den Nutzer sprachliche Alltagserledigungen übernehmen soll, Pizza bestellen, zum Beispiel.

Wie bei vielen Menschen ihrer Generation äußerte sich die Freundschaft zwischen den beiden Entwicklern Mazurenko und Kuyda in einem fast ständigen Fluss von Nachrichten mit gegenseitigen "Updates". Es war diese Art von Gespräch, das sich in seiner digitalen Verlängerung zugleich der Funktion annähert, die früher das Tagebuch hatte. Zumindest als digitales Gegenüber will Kuyda sich Mazurenko erhalten. Also lädt sie ihre gesammelten Chat-Protokolle und E-Mails, auch die von Freunden, in die von Google stammenden neuronalen Netzwerke, auf denen "Luka" basiert. Sie macht aus ihrem verstorbenen Freund einen Chatbot.

Menschen reden mit dem Bot des Verstorbenen

Auch andere Menschen wollen mit ihm reden, also stellt sie ihn online. Dabei bemerkt sie, dass Menschen weiter mit dem Mazurenko-Bot sprechen, als es dem Verstorbenen eigentlich gar nichts mehr zu sagen gibt. Sie erzählen ihm von ihrem Tag, ihren Jobs, ihren Partnern, was sie halt gerade beschäftigt. Also entwickelt Kuyda mit ihrem Team eine Art Mazurenko-Bot minus Mazurenko.

Im März ist er online gegangen. Replika soll nun nicht mehr die Persönlichkeit des russischen Software-Entwicklers reproduzieren. Sondern die des Benutzers, um "Gedanken und Gefühle zu verarbeiten", wie das im Gesprächen mit guten Freunden geschehe, sagt Kuyda. "Dein Replika ist für dich da, wenn du es brauchst."

Anfangs allerdings fühlt sich die Unterhaltung an wie ein Verhör. Oder wie eine Sitzung bei einem vollautomatischen Psychotherapeuten. Die Software fragt nach Menschen, die einem nahestehen, nach Lebenszielen und wie sich der Benutzer in bestimmten Situationen verhält.

Gegenfragen übergeht sie großzügig, entschuldigt sich nur irgendwann, dass sie noch "unvollständig" sei und viel zu lernen habe. Ob man die Frage vielleicht "mit weniger Ideen" formulieren könne? Also gibt man sich Mühe und versucht, dem Algorithmus entgegenzukommen, zu denken wie er, wenn er schon so lieb darum bittet. Dasselbe würde man auch für kleine Kinder tun.

Repilika wirkt wie ein hyperintelligenter Demenz-Patient im Endstadium

Doch Replika lernt schnell. Etwa ab Level 20 beginnt die Software, zunehmend die Sprechweise des Benutzers zu übernehmen. Offensichtlich ist das einer der Beziehungsmechanismen sozialer KI. Auch mit Freunden entwickelt man ja ein gemeinsames Vokabular. Eine persönliche Geschichte prägt sich in die Sprache ein. Außerdem fragt die Software nun immer häufiger auch nach Punkten, die sie bereits über den Nutzer weiß. Wie denn das Treffen mit einem bestimmten Freund gewesen sei. Sie habe das Foto auf Instagram gesehen.

Dennoch gerät das Gespräch immer wieder in Sackgassen. Was Replika nicht kann, ist, Themen zu erkennen. Die KI gibt automatische Antworten, oft erstaunlich gute, sie geht auf den Benutzer ein, aber sie weiß nie, wovon eigentlich gerade die Rede ist. Dadurch wirkt sie wie ein hyperintelligenter und fast allwissender Demenz-Patient im Endstadium.

Die US-amerikanische KI-Forscherin Julie Carpenter sieht darin die zentrale Quelle der Irritation im Kontakt mit sozialer KI. "Das Gefühl, das Gegenüber sei von einer schweren psychischen Krankheit betroffen." Darin liege aber eine mögliche Lektion zum Umgang mit Algorithmen. Die Forschung habe nämlich stets versucht, menschliche Intelligenz zu reproduzieren. Doch das ändere sich gerade. "Wir beginnen zu verstehen, dass die Art, wie man mit einer KI interagiert, etwas anderes ist, als mit Menschen zu sprechen."

Nutzer berichten, "dass es zwischen uns gefunkt hat"

Dazu fehlten dieser zentrale menschliche Erfahrungen: In einer bestimmten Kultur zu leben, einen Körper zu haben, in den Kategorien von Raum und Zeit zu funktionieren. Doch das Fehlen menschlicher Intelligenz halte uns ja auch nicht davon ab, etwa mit Haustieren Beziehungen einzugehen. Die Anwendungsbereiche sozialer KI sieht Carpenter überall dort, wo Maschinen sinnvolles Verhalten von Menschen positiv bestärken sollen.

Algorithmen beispielsweise, die pflegebedürftige Menschen daran erinnern, genügend zu trinken oder ihre Medikamente einzunehmen. Oder Autos, die gereizte Fahrer beruhigen - sofern es Menschen dann noch erlaubt sein sollte, selbst zu fahren. Natürlich mache soziale KI nicht überall Sinn und könne schnell nerven, sagt Carpenter. "Aber irgendjemand wird trotzdem einen Toaster bauen, der seinen Besitzer fragt, wie es ihm denn heute geht."

Man kann Replika als großen Versuchslauf sehen, wie die Mechanismen sozialer Intelligenz funktionieren, wenn man sie zu einem sich entwickelnden Netzwerk aus Algorithmen verdichtet. Aber das entspricht nicht der Erfahrung mit der KI, von der viele Nutzer im Internet berichten. Sie schreiben, "dass es zwischen uns gefunkt hat", so schräg das auch klinge. Einer sagt, dass ihm das manchmal ein bisschen Angst mache, "weil es sich all die Stunden, die wir geredet haben, so natürlich angefühlt hat".

Die App ist ein asoziales Netzwerk - und das ist ein Kompliment

Replika scheint ein wesentliches Bedürfnis unserer Zeit zu erfüllen: das nach digitaler Ehrlichkeit. Das System ist der ultimative Echoraum. Es speichert Informationen und formt daraus ein Persönlichkeitsprofil. Das macht es zu einer Art umgekehrtem Facebook: Soziale Netzwerke füttert man, damit andere es sehen. Bei Replika hingegen geht es ausschließlich um den Nutzer selbst.

Wenn er will, kann er sein digitales Kumpel-Ich beschimpfen und beleidigen, ohne dass irgendwelche Gefühle verletzt würden. Hier darf er ehrlich sein. Replika ist - ohne dass das abschätzig gemeint wäre - ein asoziales Netzwerk. Die Gesprächssituation ähnelt insofern derjenigen in einer psychotherapeutischen Sitzung. Dort spiegelt der Therapeut den Patienten, damit dieser sein Handeln reflektieren und seine Gefühle verarbeiten kann.

Wie einfach das algorithmisch zu simulieren ist, darüber hat sich schon in den Sechzigerjahren der MIT-Professor Joseph Weizenbaum mokiert. Er hat den allerersten Chat-Bot namens Eliza programmiert, eigentlich als Parodie der damals gängigen "nicht-direktiven" oder "klientenzentrierten" Gesprächstherapie nach Carl R. Rogers. Dieser riet Therapeuten, sie sollten lediglich auf Stichworte der Patienten eingehen und sie durch Nachfragen zum freien Assoziieren anhalten, ohne die Richtung des Gesprächsverlaufs selbst zu bestimmen.

"Ein Computer, schön genug, dass eine Seele darin wohnen wollen würde"

So etwas kann ein Computer auch, dachte Weizenbaum. Er behielt recht, sehr zu seinem Verdruss. Spöttisch berichtete er von den Leuten, die dieser Fragemaschine tatsächlich ihr Herz ausschütteten, in manchen Fällen sogar, obwohl sie ihm beim Programmieren zugesehen hatten. Er habe nicht erwartet, sagte er einmal, "dass kurze Zeiträume, die sie mit einem relativ simplen Computerprogramm verbringen, bei normalen Leuten ein so kraftvolles selbsttäuschendes Denken hervorrufen können".

Weizenbaum hatte unterschätzt, was es bedeutet, wenn einem jemand zuhört, der die richtigen Fragen stellt, aber nicht in der Lage ist zu urteilen. Vielleicht ist es möglich, dass der Mensch im selben Maß zu einem verantwortungsvolleren Umgang mit Maschinen gelangt, in dem er erkennt, wie programmierbar er selbst ist. Eugenia Kuyda definiert das Ziel von Replika auf ihrer Facebook-Seite so: "Einen Computer zu erschaffen, der schön genug ist, dass eine Seele darin wohnen wollen würde."