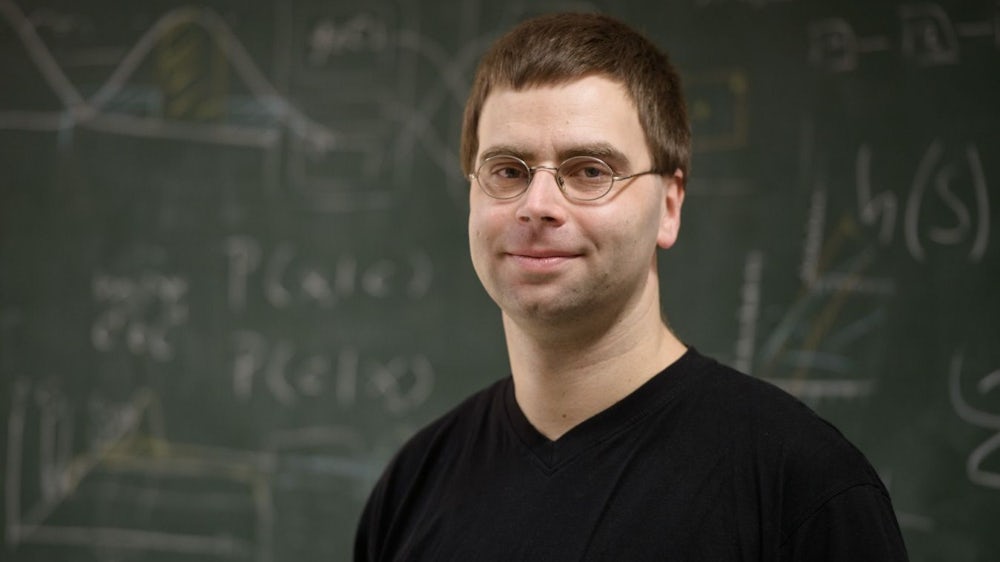

Morgens E-Mails an Freunde senden, nachmittags im Internet einkaufen, abends Fotos in sozialen Netzwerken posten: Jeder Internetnutzer produziert täglich Daten. Die Masse der weltweit vorhandenen Informationen verdoppelt sich Schätzungen zufolge alle zwei Jahre. Diese Datenmasse interessiert neben Unternehmen, die damit Geld verdienen wollen, auch Wissenschaftler wie Matthias Hagen. Hagen ist Inhaber der ersten deutschen Professur für Big Data Analytics an der Bauhaus-Universität Weimar.

Hagen leitet eine vom Bundesministerium für Forschung und Bildung geförderte Gruppe von Wissenschaftlern, seine Professur wird von regionalen Unternehmen finanziert. Ziel der Forscher: neue Techniken der Datenanalyse zu entwickeln. Einen Schwerpunkt setzen Hagen und seine Kollegen bei der Frage, wie sich Suchmaschinen verbessern lassen.

Die funktionieren zur Zeit am besten, wenn Nutzer wenige Schlagwörter eingeben. Diese Begrenztheit möchte Matthias Hagen gerne auflösen. "Das Informationsbedürfnis steigt, aber Mainstream-Suchmaschinen helfen nicht bei explorativeren Suchen wie beispielsweise der Literaturrecherche. Sie liefern oft auch keine sinnvollen Ergebnisse, wenn der Nutzer komplette Fragen eingibt. Da setzen wir an."

Nachlassende Erinnerung

Hagen kann sich vorstellen, dass ein Nutzer, der eine komplette Frage eingibt, gleich ein How-to-Video angezeigt bekommt. Heute landet man seiner Meinung nach noch zu oft auf Frage-und-Antwort-Plattformen, die nicht unbedingt die richtige Antwort geben. Der Fachbegriff dafür, dass das vor allem Suchmaschinen klüger werden sollen, lautet " semantisches Web".

Auch das Problem, dass das Erinnerungsvermögen mit der Zeit etwas nachlässt, möchte Hagen mit besseren Suchalgorithmen lösen. "Ich habe vor drei Jahren ein Buch gelesen, erinnere mich aber nicht mehr an den Autor, nur noch an Bruchstücke des Titels und einzelne Gegebenheiten aus dem Text. Dann sollte es eine Suchmaschine leisten, dass sie mir mit diesen bruchstückhaften Angaben schließlich Autor und Name des Buches anzeigen kann." Weitere denkbare und sinnvolle Anwendungen sind für Hagen, dass Suchmaschinen anhand von Zitaten weitere Werke finden, in denen diese Zitate genau so oder ähnlich vorkommen. Das helfe einerseits dabei, Plagiate aufzuspüren, andererseits dabei, Texten zu finden, die sich mit ähnlichen Themen befassen.

Damit Hagen und sein Team bessere Suchmaschinen mit besseren Algorithmen entwickeln können, brauchen sie sehr viele Daten, die ihnen zeigen, wie Internetnutzer suchen, wie und welche Begriffe sie dabei formulieren. An diese Daten zu kommen, ist allerdings nicht so einfach. Zum einem, weil die Forscher nicht über die Informationsmengen verfügen, auf die beispielsweise Google mit drei Milliarden Suchanfragen am Tag zugreifen kann. Zum anderen gilt es für die Forscher, den Schutz der Daten zu gewährleisten. So kam man in Weimar auf die Idee, den "idealen Nutzer" zu simulieren. Grundlage dieser Simulationen sind Modelle, in denen für die Suche Kosten-Nutzen-Modelle erstellt werden. Kosten sind beispielsweise: wie viel Zeit und wie viel geistigen Aufwand ein Nutzer in sein Informationsbedürfnis investiert.

Verschiedene Nutzertypen

Eine Rolle spielt auch, ob der Nutzer über einen PC oder über ein Smartphone sucht. So geben laut Hagen Smartphone-Nutzer für eine Suche mehr Begriffe als PC-Nutzer ein. Für den "idealen" Nutzer kombinieren die Forscher nun eine enorme Anzahl von Nutzertypen in einem Schema. So wollen sie herausfinden, welche Suchoption am effektivsten ist.

Ein Ergebnis der Weimarer Forschung ist die Suchmaschine netspeak.org. Dort können Nutzer nach den häufigsten englischen Phrasen suchen. Die Suchmaschine zeigt an, wie häufig bestimmte Wortkombinationen im Netz vorkommen und gibt so entscheidende Hinweise, welche die korrekte Redewendung sein könnte. Neue Werkzeuge und bessere Suchalgorithmen können laut Hagen beispielsweise die herkömmlichen Taxonomien in Bibliotheken verändern. Anstatt starrer Klassifikationen könnten Bibliotheken auch nach Nutzersuchen und verwandten Suchanfragen geordnet werden.