In dem lieben Internet, das wir den ganzen Tag benutzen, soll bitte alles an seinem ordentlichen Platz sein. Die Grausamkeiten und Verbrechen des echten Lebens gehören auf die Nachrichtenseiten, moderiert und nicht explizit gezeigt. Für Pornografie und sexuelle Spezialinteressen gibt es separierte Angebote. Männer, die ihre Frauen verprügeln oder ihre Feinde in Blutlachen auflösen, haben ihren Ort in Serien und Spielen. Und das ganz finstere Zeugs möchte bitte nur die Polizei entdecken. Darin sind sich die großen Anbieter von Web-Produkten relativ einig mit der Mehrzahl ihrer Kunden.

Aber leider ist die Welt nicht lieb, ihr Abbild im Internet auch nicht. Wer sorgt also dafür, dass wir bei Facebook kein Profilbild sehen, das einen abgehackten Kopf zeigt, bei Youtube kein Video mit Kindesmissbrauch finden oder bei Instagram Grumpy Cat nicht in einer Serie mit geschredderten Küken und gehäuteten Hunden auftaucht? Die meisten User zerbrechen sich darüber kaum den Kopf oder glauben, tolle Algorithmen aus Silicon Valley sorgen dafür, dass nicht unfreiwillige Schocks unsere Digitalmedienabhängigkeit stören. Aber kann die automatisierte KI wirklich eine entblößte Brust auf einem Tizian-Bild von einem Nacktselfie unterscheiden, Ironie von Hetze oder inszenierte von echter Gewalt?

Schmutzarbeit wird auf die Philippinen outgesourct

Die Mark Zuckerbergs dieser Welt glauben das jedenfalls nicht - auch wenn sie das auf keinen Fall zugeben wollen. Vielmehr beschäftigen die großen Digitalkonzerne Zehntausende Tatortreiniger, die rund um die Uhr die sozialen Medien und alle anderen Angebote putzen, die davon leben, dass ihre User etwas hochladen. Möglichst bevor ein Bild, ein Video, ein Text erscheint, macht dieser Content eine kleine Reise auf die Philippinen, wo ein Heer junger Jobber vor Bildschirmen sitzt und in Sekunden darüber entscheiden muss, ob der Nippel auf dem briefmarkengroßen Jpeg Renaissance-Kunst ist oder Selbstentblößung, veröffentlicht oder gelöscht wird.

"Die Müllabfuhr im Internet" hieß deshalb eine Veranstaltung der Heinrich-Böll-Stiftung in Berlin sehr passend, die sich diesem aufwendig verdrängten Thema der Mediendemokratie widmete, über das es nur sehr wenige Informationen gibt. Denn die Schattenarmee, die in neonbeleuchteten Großraumbüros die moralische Verwerflichkeit der zivilisierten Welt im 24/7-Akkord ungesehen machen soll, ist zum Schweigen verdammt. Laut der Verpflichtung, die jeder Mitarbeiter dieser digitalen Putzkolonnen unterschreiben muss, dürfen sie nicht einmal ihren Partnern davon berichten, was sie den ganzen Tag über sehen müssen - falls eine Partnerschaft nicht sowieso von diesem Job zerstört wird.

Arbeiter berichten von Libidoverlust, Depressionen und Paranoia

Recherchen in Manila, die der deutsche Theatermacher Moritz Riesewieck und die amerikanische Medienwissenschaftlerin Sarah T. Roberts in Berlin vorstellten, brachten gravierende psychologische Begleiterscheinungen zutage. Von Libidoverlust über Schlafstörungen zu Depressionen, Alkoholismus und paranoidem Misstrauen gegenüber anderen Menschen reichen die Leiden, die das stumme Verschließen des Bilderhorrors im eigenen Kopf erzeugt.

"Commercial Content Moderation" (CCM) nennen die Firmen verschleiernd das Geschäft in den "Digital Sweatshops", das in vielem den globalisierten Strukturen des Warenverkehrs gleicht. Auch bei der Bildproduktion wird die Schmutzarbeit ausgelagert. Autonome Unternehmen in Billiglohnländern nehmen den sauberen Marken nicht nur die ungeliebte Arbeit zu niedrigen Kosten ab, sondern auch die Verantwortung für die Gesundheit der Mitarbeiter. Um die Folgeschäden von täglich zehn Stunden Schocksortieren, so Riesewieck und Roberts in ihren Vorträgen, kümmern sich die Subunternehmer in der Regel nur, indem sie diejenigen, die nicht vorher schon gekündigt haben, nach spätestens zwei Jahren entlassen. Schweigen müssen sie weiterhin.

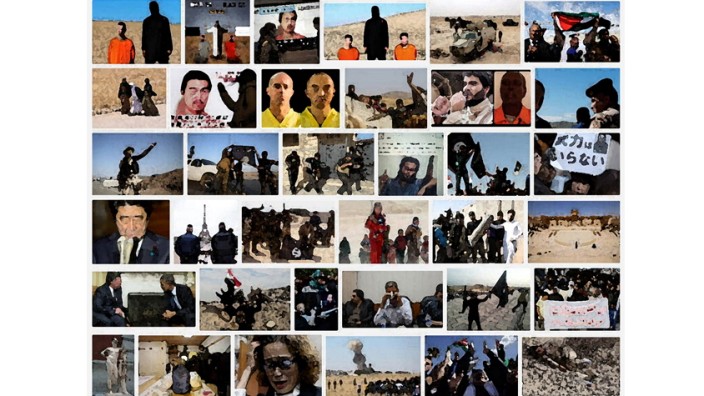

Wenn Terroristen enthaupten, passt das ins Weltbild

Die oft beschriebene Intransparenz von Unternehmen wie Facebook, Google oder Twitter, die immer noch als Orte der freien Meinungsäußerung von ihren Kunden missverstanden werden, ist aber nicht nur bei der Verheimlichung ihrer ungesehenen Inhalte und den Umständen ihres Verschwindens besonders eklatant. Auch die Kriterien, nach denen die Maus in Manila zwischen Löschen und Veröffentlichen entscheidet, kommen höchstens mal durch einen Whistleblower an die Öffentlichkeit. Das empfinden vermutlich die meisten Menschen nicht als besonders belastend, wo es sich um die Abbilder von Verbrechen und grausame Motive handelt. Aber das Löschen betrifft eben auch kulturelle, politische und religiöse Dissensthemen.

So berichtete Sarah T. Roberts von der publik gewordenen Unterscheidung bei amerikanischen Netzwerk-Riesen, die inhaltsgleiche Gewaltdarstellung entsprechend politischer Prämissen unterschiedlich behandeln. Das Köpfen der Terrormiliz IS in Syrien und dem Irak wird nicht entfernt, da es atmosphärisch der amerikanischen Außenpolitik dient, wogegen ähnliche Gewaltakte im mexikanischen Drogenkrieg unterschlagen werden, vermutlich, weil sie wirtschaftlichen Interessen schaden. Aber auch die Frage, was "Hate Speech" ist, entzieht sich öffentlicher Kontrolle. Ob fremdenfeindliche, rassistische oder fundamentalistische Kommentare das Licht des Flachbildschirms erblicken oder nicht, entscheiden nicht Behörden, sondern kleine Zirkel der Konzerne.

So "kuratieren" an Profit orientierte Wirtschaftsunternehmen im Geheimen die Standards der öffentlichen Diskussion, oder anders gesagt: Zensur ist eine Sache von privaten Geschäftsinteressen. Und leider auch die Strafverfolgung. Denn die brutalen Bilder, die junge Philippiner aus dem nie versiegenden Brunnen der Schrecklichkeiten fischen, sind ja oft Abbild konkreter Verbrechen. Vernichten diese Tatortreiniger also in ihren Sekundenentscheidungen ständig Beweise für Straftaten, anstatt sie den Ermittlungsbehörden zu liefern?

Soziale Netzwerke schleichen sich aus der Verantwortung

Offiziell behaupten mittlerweile alle Internetunternehmen, eine Pipeline zur Polizei zu unterhalten. Aber, so die an diesem Abend ebenfalls vertretene Vorsitzende der Digitalen Gesellschaft, Geraldine de Bastion: Die Intransparenz dieser Unternehmen mache es der Öffentlichkeit vollkommen unmöglich, das nachzuprüfen. Facebook etwa könne man nicht direkt kontaktieren, nicht einmal, wenn man Profile von IS-Terroristen entdeckt. Das ethische Gebaren der Netzriesen sei deswegen vor allem Propaganda und für verantwortungsvolle Konsumenten eine weitere Nutzung der großen sozialen Netzwerke kaum zu verantworten. "Es wäre eine echte Chance für einen cleveren Unternehmer", empfahl deswegen Sarah T. Roberts, "endlich eine ethische Plattform zu gründen".

Aber auch die "ethische" Plattform stünde vor dem Problem, wem man das Filtern schockierender Inhalte zumuten darf. Würden sehr gute Bezahlung, intensive psychologische Betreuung und konsequente Zusammenarbeit mit den Kriminalern - was die Konzerne viel Geld kosten würde - etwas daran ändern, dass authentische Videos von Kindesmissbrauch, Folter und Tötungen die mentale Gesundheit angreifen? Oder will man wirklich darauf hoffen, dass Computerprogramme den echten Horror sicher identifizieren? Das funktioniert derzeit noch nicht einmal bei Texterkennung: "Man kann beobachten", so Roberts, "dass User eine extreme Kreativität entwickeln, um rassistische Inhalte so zu formulieren, dass die Software sie nicht entdeckt."

Diese Dilemmata lassen sich kaum zufriedenstellend lösen. Aber das koloniale Gebaren, unseren Psycho-Müll in Asien abzuladen, müsste eigentlich einer genauso intensiven Globalisierungskritik unterzogen werden wie die Kinderarbeit.