Die Welt ist voller Wunder, zumindest aus Sicht einer Kamera. Da wird der Zirkuselefant zum Fußgänger und der Steinlöwe zum braven Haustier. Jedes Kind wüsste es besser als die Bilderkennung. Was nicht im voraus etikettiert ist, muss die künstliche Intelligenz erraten. Deshalb erscheinen rosa Elefanten auf dem Bildschirm und die Statuen vor der Einfahrt leuchten rot. Die Signalfarbe warnt vor Tieren. Da die Löwen schön Sitz machen, fährt das autonome Auto weiter durch seine schwer verständliche Welt.

"Wir müssen uns Stadt für Stadt erobern", erläutert Uwe Franke. Der Leiter Bildsemantik bei Daimler trainiert sein Kamerasystem gezielt auf das jeweilige Einsatzgebiet. Ob exotische Verkehrsschilder, verwickelte Kreuzungen oder Hydranten, die wie Kinder aussehen: "Was bei Testfahrten nicht richtig erkannt wird, klassifizieren wir im Nachgang. Dadurch verbessern wir die Erkennungsleistung um einige Prozente." Anders als beim maschinellen Lernen im Internet kann jeder Fehler gravierende Folgen haben. Ein tödlicher Tesla-Unfall hat die Weltöffentlichkeit vor zwei Jahren aufgerüttelt: Per Autopilot war ein Model S in einen querenden Lastwagen gerast. Die Kamera hielt den weißen Lkw für eine Brücke, unter der man durchfahren kann. Tesla konnte die Schuld auf den Fahrer abwälzen, weil es sich um ein Assistenzsystem handelt (Level zwei). Bei einem autonomen System müssten die Autohersteller jedoch haften. Deshalb nutzen sie viele verschiedene Sensoren.

Lange waren rollende Roboter eine Disziplin für Forscher und Verrückte. Daimler und Bosch hatten vor 20 Jahren zwar das Radar ins Auto gebracht. Solche Abstandstempomaten erfassen aber nur einen kleinen Ausschnitt der Wirklichkeit. Google/Waymo setzte vor rund zehn Jahren erstmals Lidar-Scanner ein, um das Umfeld zu erfassen. Anders als damalige Radare können die Laserstrahlen Fußgänger zuverlässig erkennen. Außerdem unterfüttern sie Kamerabilder, die eigentlich nur Winkel beschreiben, mit dreidimensionalen Messdaten. Trotzdem haben die Autohersteller zugeschaut, wie Waymo Millionen Testkilometer mit den teuren Supersensoren abspulte. 2013 fuhr eine Mercedes S-Klasse selbständig von Mannheim nach Pforzheim. Das Schönwettersystem aus Radar und Stereokamera funktionierte aber nur auf Landstraßen zuverlässig.

Erst seit zwei Jahren gibt es genug Computer-Power im Auto, um die Daten in Echtzeit auszuwerten

"Mit der Kamera kann man 80 Prozent der Fälle abdecken", sagt Elmar Frickenstein, Leiter autonomes Fahren bei BMW: "Spannend wird es bei den letzten 20 Prozent. Da kommt man mit einem Sensortyp nicht weiter. Die hohe Kunst ist die Sensordatenfusion auf der Basis von Rohdaten." Mehr als 30 Kameras, Radare und Lidare tasten das Umfeld von autonomen Testwagen mittlerweile ab. Sie liefern Gigabytes an Daten, die in Echtzeit ausgewertet werden. Erst seit zwei Jahren haben automobiltaugliche Grafikkarten überhaupt die Rechenpower, um diese Informationsflut zu bewältigen.

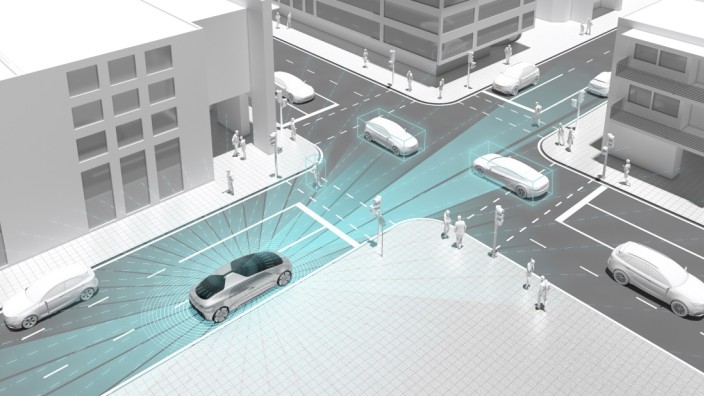

Vier Augen sehen mehr als zwei: Nach diesem Prinzip werden vollautonome Autos mit über 30 Sensoren vollgepackt: Die Eigenschaften von Radar, Lidar, Kamera und Ultraschall ergänzen sich zu einem Umfeldmodell.

(Foto: BMW)Anders als bei Assistenzsystemen werden die Objekte nicht von jedem Sensorchip einzeln erkannt. Stattdessen ist die Leistung von sechs der besten Hochleistungsrechner nötig, die man für Computerspiele kaufen kann, um die Rohdaten zentral zu sortieren. Neuronale Netze mit 128 Ebenen durchsuchen nicht nur die jeweils 1,3 Millionen Messpunkte von fünf Lidar-Sensoren, sondern auch die zwei Millionen Bildpunkte jeder Kamera - multipliziert mal 20 Bilder pro Sekunde. Die zweidimensionale Weltsicht von Kamera und Radar kollidiert mitunter mit dem 3-D-Verfahren des Lidars. Trotzdem soll das schwankende System verstehen, was um es herum passiert.

Ohne Sicherheitsfahrer kommen Robotertaxis im normalen Stadtverkehr noch nicht zurecht. Viel einfacher ist die Lösung für eine Schnellstraße ohne Fußgänger. VW-Konzernforscher haben seit 2013 so einen Autobahnpiloten entwickelt. 2015 konnten sie auf der Computermesse CES einen entsprechend umgebauten Audi A7 präsentieren. Ab 2020 soll das relativ einfache und erschwingliche Seriensystem auch in Deutschland selbständig von der Einfahrt bis zur Ausfahrt navigieren. Der Mensch hinter dem Steuer darf die Augen von der Straße lassen - solange nichts Außergewöhnliches passiert. Aufgeschmissen wäre so ein Level-drei-System bei sehr schlechtem Wetter oder im Chaos nach einem Unfall. Rosa Elefanten oder rote Steinlöwen sind also nur ein Teil des Problems.

Was, wenn ein Mensch mitten auf der Straße steht und gestikuliert?

Wie bei jedem Einsatz von künstlicher Intelligenz haben die Maschinen Schwierigkeiten, mit widersprüchlichen Informationen umzugehen. Im neuen BMW Campus für autonomes Fahren in Unterschleißheim arbeiten allein 1500 Mitarbeiter an den Tücken der Technik. Oder besser gesagt: An den Tücken des typisch chaotischen Stadtverkehrs. Was, wenn zum Beispiel ein Mensch mitten auf der Straße steht und gestikuliert? Schulkinder würden den gestischen Anweisungen wohl folgen oder zumindest nachfragen. Doch das können autonome Autos nicht. BMW hat 60 Experten im Entwicklungszentrum Shanghai auf das Problem der Gestenerkennung von Verkehrspolizisten angesetzt. Ein Roboter, der ratlos vor dem Uniformierten stehen bliebe, wäre wohl das Dümmste, was dem Milliardenprojekt passieren könnte.

Viele Fragen rund um das autonome Fahren gehen weit über die konventionelle Automobilentwicklung hinaus. Im Roboterrennen liegen daher die beiden weltweit führenden Suchmaschinengiganten vorne: Der chinesische Internetkonzern Baidu agiert weniger als Privatfirma, sondern als nationaler Champion, der technische Standards für die Regulierungsbehörden entwickelt. Mehr als 140 Partner hat der IT-Konzern auf seiner offenen Apollo-Plattform versammelt; BMW und Daimler sitzen sogar im Apollo-Vorstand. "Automatisiertes Fahren und Konnektivität entwickeln sich in China mit beispielloser Geschwindigkeit", sagt Daimler-Chef Dieter Zetsche. Die Stuttgarter wollen ihre Partnerschaft mit den Chinesen unter anderem mit lokalen Dienstleistungen rund um das automatisierte Fahren ausbauen. Nicht nur die Technik, sondern die Art, in der Stadt mobil zu sein, soll sich in wenigen Jahren grundsätzlich ändern.

"Wir würden gerne mit Robotertaxis in Europa starten, aber die Gesetzgebung in den USA ist weiter"

Der westliche Hotspot für autonomes Fahren ist Kalifornien: Seit Mai dürfen dort Autos ohne Lenkrad und Pedale auf die Straße. "Wir würden gerne mit Robotertaxis in Europa starten, aber die Gesetzgebung in den USA ist weiter", sagt Johann Jungwirth, der für selbstfahrende Autos im Volkswagen-Konzern zuständig ist: "Mit einem US-Gesetz für vollautonomes Fahren auf Bundesebene rechnen wir im Frühjahr 2019." Spätestens 2021 will Jungwirth mit großen Flottentests in Nordamerika beginnen. Die Kooperation von Daimler und Bosch wird noch früher zahlende Kunden an Bord nehmen. Bereits im zweiten Halbjahr 2019 wollen die schwäbischen Weltkonzerne im Silicon Valley zeigen, was sie draufhaben. Noch liegt Waymo im Ranking der kalifornischen Verkehrsbehörde vorn. Im Durchschnitt schaffen die Roboterautos eine Distanz von 9000 Kilometern, bevor ein Sicherheitsfahrer eingreifen muss.

Der Grund, warum Baidu, Waymo oder der Fahrdienstvermittler Uber Milliarden in die Entwicklung von Robotertaxis stecken, ist einfach: Nur die wenigsten Privatkunden werden ihren Neuwagen mit Technik für mehr als 20 000 Euro aufrüsten, um autonom durch die Stadt zu fahren. Im kommerziellen Dauereinsatz sieht die Rechnung anders aus. Geteilte Hightechautos können ihre hohen Einmalkosten relativ zügig wieder einspielen. Eine Reihe von Studien rechnen vor, dass dieses Carsharing 4.0 die Geschäftsmodelle aller Autohersteller revolutionieren wird. Immer vorausgesetzt, dass die Semantikmaschinen fehlerlos arbeiten und ihre Passagiere nicht wegen einer Computerpanne zu Fuß gehen lassen. Wenn Waymo ab diesem Herbst Fahrgäste mitnimmt, geht es also nicht nur um Sicherheit, sondern auch um Fragen des Komforts. Notbremsungen wie bei einem Autorennen sind tabu. Ein siebter Sinn ist deshalb die Königsdisziplin des autonomen Fahrens: Wie ein geübter Chauffeur soll die Maschine voraussagen, was die anderen Verkehrsteilnehmer als Nächstes tun werden.

Das größte Hindernis für Robotertaxis ist aber nicht die Technik, sondern die Bürokratie. Anders als die USA und China sind die Europäer an das ECE-Abkommen der UN vom 20. März 1958 gebunden. Daher werden neue Normen für automatische Lenksysteme nicht in Berlin oder Brüssel, sondern von der Arbeitsgruppe der Vereinten Nationen in Genf beschlossen. Mehrmals wurde die Weiterentwicklung schon vertagt. Klar ist bisher nur, dass Teslas Autopilot eine gesetzliche Grauzone in Europa nutzt. Nun wird nachreguliert. Der Fahrer muss künftig öfter ins Lenkrad greifen als bisher. Wann Kollege Computer komplett übernehmen kann, ist völlig offen.